来源(公众号):大数据AI智能圈

昨天一个老同事找我诉苦,说他们公司为了做数据整合,光是协调各个部门开会就开了三个月。我一听就笑了,这不就是我三年前的状态吗?

那时候我在一家电商公司做数据分析师,老板突然要求做全渠道数据整合。我天真的以为就是把各个系统的数据导出来整理一下就行了,结果这一做就是大半年,整个人都快疯了。

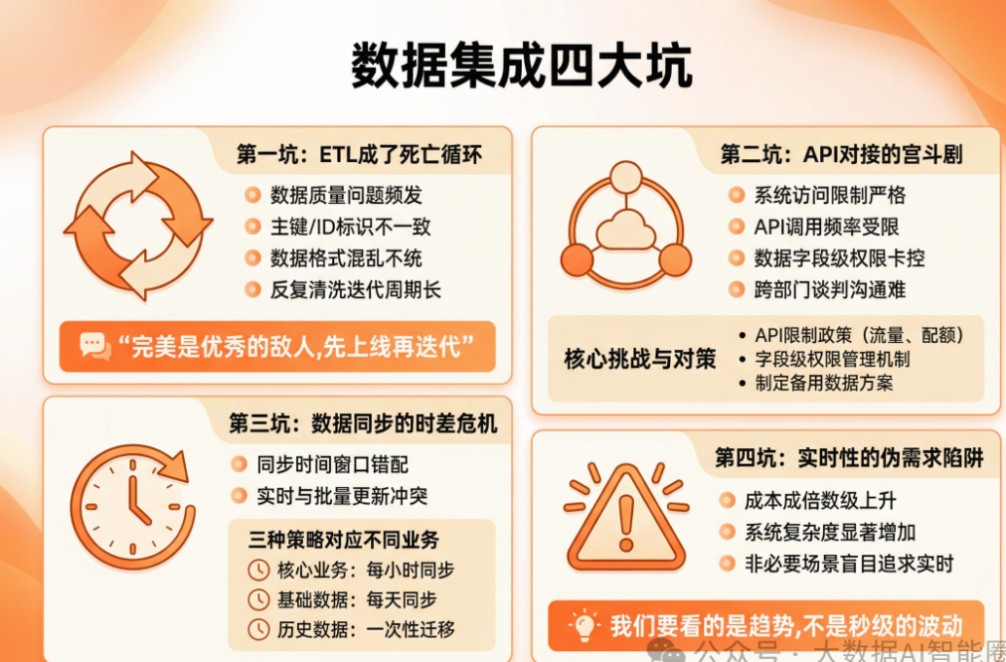

第一坑:ETL成了死亡循环

刚开始做ETL的时候,我和大部分人一样,野心勃勃地想把所有数据都清理得干干净净。

订单表、用户表、商品表、库存表,一个都不能少。

结果呢?光是订单数据我就搞了两个月。

为啥?因为数据质量问题层出不穷:

同一个订单在不同系统里的ID不一样

用户注册时间格式混乱,有yyyy-mm-dd的,有dd/mm/yyyy的

商品名称各种奇葩写法,"iPhone 12 Pro Max 256GB 深空灰色"和"苹果12PM256G深灰"居然是同一个东西

我每天的生活就是:清洗数据→发现新问题→重新清洗→又发现问题→继续清洗...

直到有一天,我老板实在看不下去了,把我叫到办公室说:"小王啊,你这是要清洗到退休吗?"

我这才恍然大悟,ETL不是一次性工作,分阶段来做才是王道。

先把核心业务数据能用起来,其他的慢慢优化。

完美是优秀的敌人,先上线再迭代才是王道。

第二坑:API对接的宫斗剧

解决了ETL问题后,我以为最难的部分过去了。

结果API对接才是真正的噩梦。

你想和别的系统对接数据?没那么简单。

每个系统都有自己的脾气:

财务系统说:"我们的API只对内部开放,外人想都别想"

物流系统回:"调用次数有限制,一天最多1000次"

CRM系统更绝:"数据可以给,但是敏感信息不能包含"

我就像个外交官一样,到处游说各部门开放数据接口。

有个系统的负责人特别有意思,我去找他谈API对接,他直接来了一句:"我们系统运行得好好的,为什么要给你们数据?万一出了问题谁负责?"

没办法,我只能使出杀手锏:"王总,这个数据整合是老板要求的,而且整合后您的报表准确率能提升30%,绩效考核会有加分。"

这一招果然管用,第二天就收到了API文档。

API对接的经验总结:

一定要搞清楚对方的API限制政策

数据权限要精确到字段级别,不能贪多

要有备用方案,API不可用的时候怎么办

第三坑:数据同步的时差危机

数据整合完了,我们都很兴奋,以为大功告成了。

结果第一次给老板演示就出大事了。

老板问:"这个月的GMV数据怎么样?"

我打开仪表盘一看:"比上月增长了15%"

老板皱着眉头:"不对啊,我刚才看的财务系统,增长了30%"

我当场就懵了。

后来查原因才发现,我们的数据同步是每天凌晨2点跑的,而财务系统的数据是实时更新的。

这中间差了十几个小时,业务早就不一样了。

从那以后我明白了,数据同步策略要根据业务需求来定:

核心业务数据:增量同步,每小时更新

基础数据:全量同步,每天更新

历史数据:一次性同步,不需要频繁更新

第四坑:实时性的伪需求陷阱

经历了前面几个坑后,我开始迷信实时性。

觉得数据不实时就是落后,于是拼命研究各种实时数据捕获技术。

CDC、消息队列、流计算,能上的都上了。

系统是够实时了,但是问题来了:

成本急剧上升,光是服务器费用就翻了三倍

系统复杂度增加,维护难度呈指数级增长

大部分业务其实并不需要真正的实时数据

有一次我和运营总监聊天,他说了句特别实在的话:"我们要看的是趋势,不是秒级的波动。你给我昨天的数据就够了。"

这句话让我醍醐灌顶。

从那以后,我开始重新审视每种技术的适用场景,而不是一味追求高大上。

结语:数据集成是一场修行

做了这么多年的数据集成,我最大的感悟就是:技术只是工具,业务需求才是根本。

不要为了技术而技术,不要为了炫技而炫技。

每一种数据集成方案都要从业务场景出发,问自己三个问题:

这个数据业务方真的需要吗?

多快的更新频率能满足需求?

投入产出比是否合理?

数据集成就像修房子,基础要牢,但不一定要用最好的材料;外观要美,但不一定要追求豪华。实用、稳定、可维护才是王道。

现在如果有人问我数据集成有什么秘诀,我会告诉他:先小后大,先简后繁,先业务后技术。

因为,最好的数据集成方案不是技术最复杂的,而是业务最认可的。