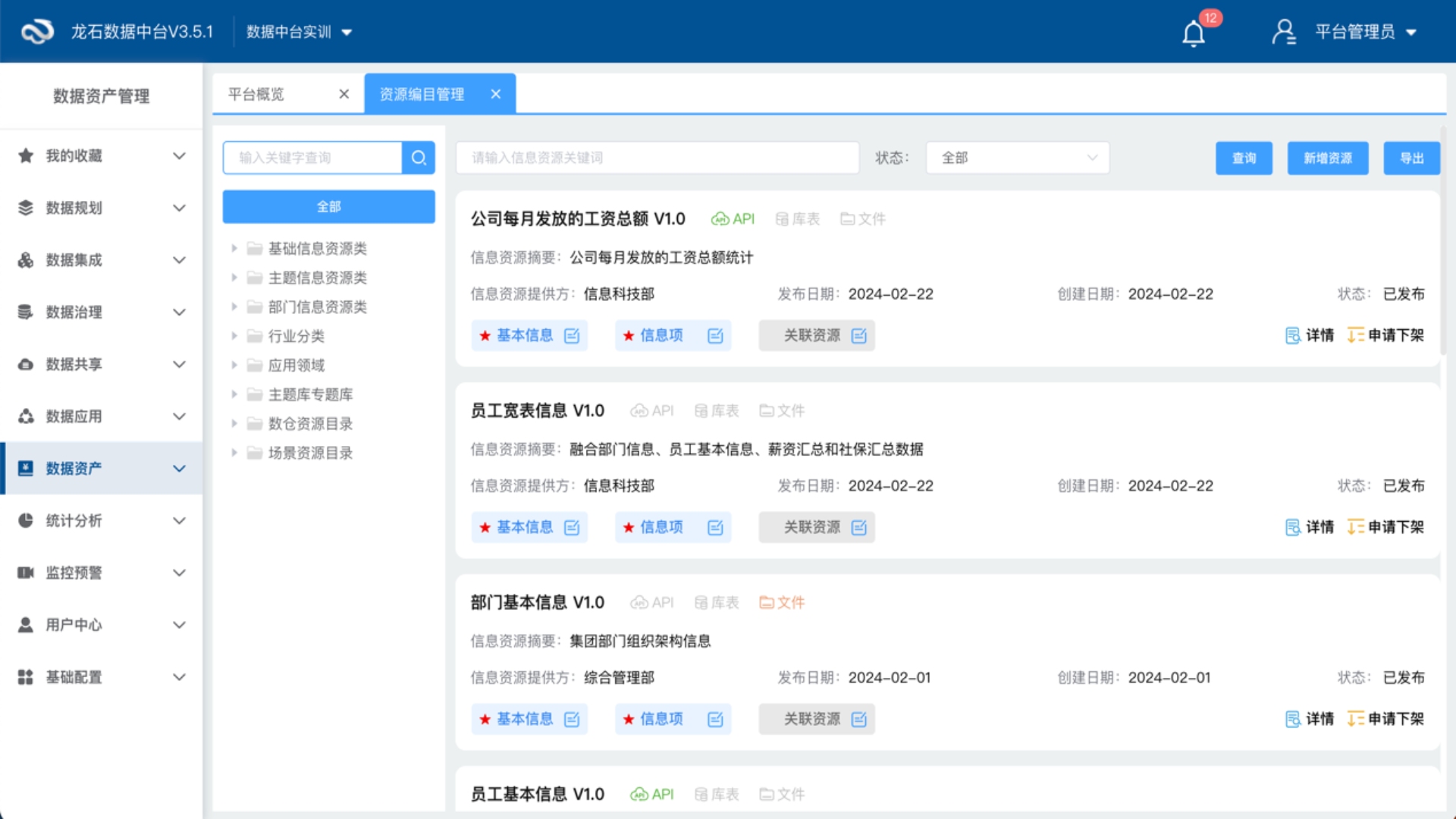

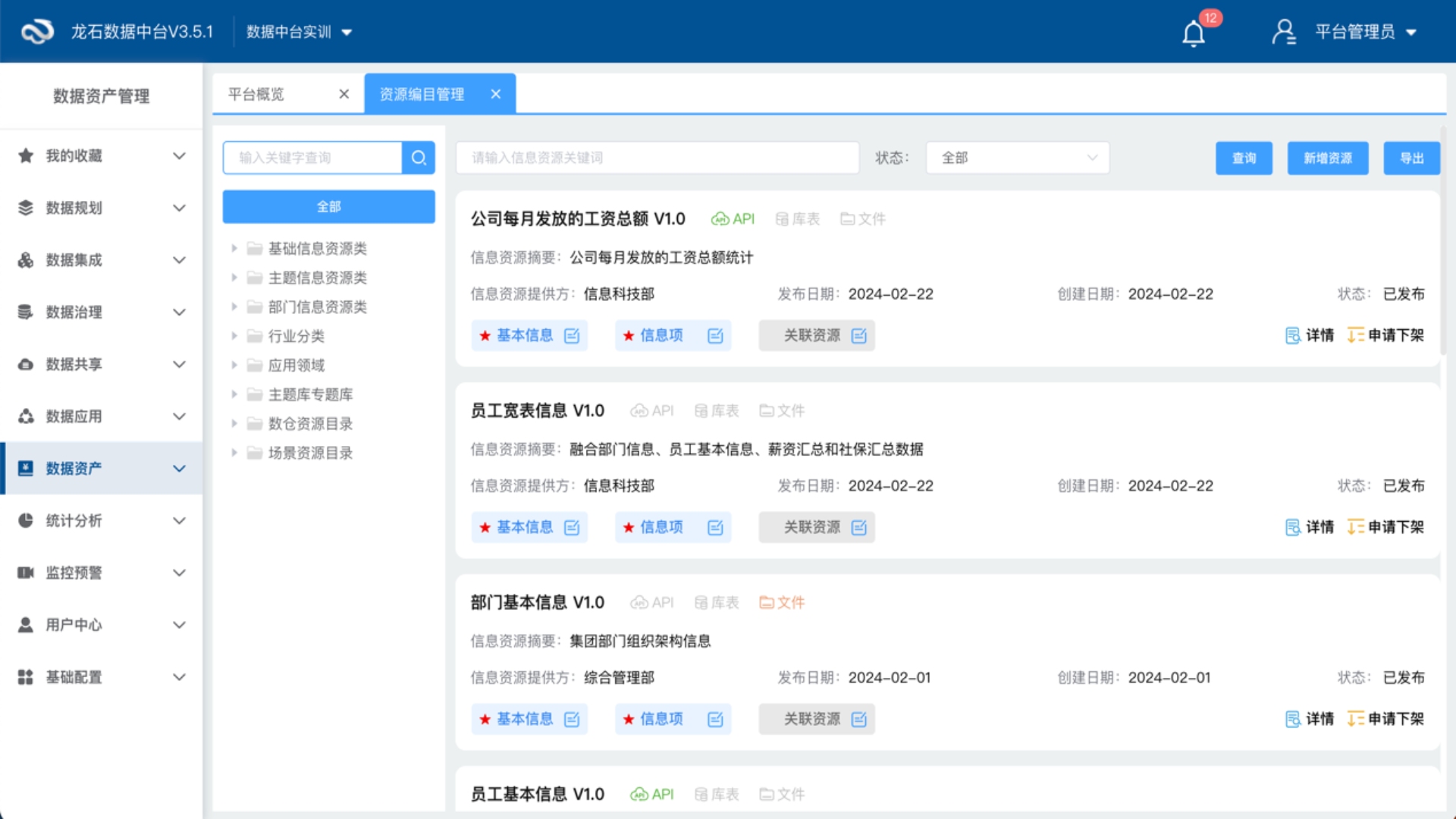

数据中台(大数据平台)之数据资源目录

数据资源目录是数据管理的账本,是数据应用的基础,更是是数据治理成果的体现,因此数据中台产品应提供数据资源目录编制、发布、资源挂载、下架的管理能力。

2024-08-16 17:50 2864

热门文章

- 1 《数据治理实战指南》 《数据治理实战指南》【第四部分 实战篇】第14章 数据治理实战演练

- 2 《数据治理实战指南》 《数据治理实战指南》【第三部分 实施篇】第13章 数据价值应用

- 3 《数据治理实战指南》 《数据治理实战指南》【第三部分 实施篇】第12章 数据安全管理

- 4 《数据治理实战指南》 《数据治理实战指南》【第三部分 实施篇】第11章 主数据管理

- 5 公司动态 服务升级 | 龙石数据全国统一服务热线正式启用!

- 6 公司动态 《数据治理实战指南》 赋能客户成为数据治理实战专家 | 龙石数据《数据治理实战指南》核心内容速览|全流程实战干货+即用模板

- 7 《数据治理实战指南》 《数据治理实战指南》【第三部分 实施篇】第10章 数据质量管理

- 8 荣誉奖项 龙石数据获苏州政务领域双重肯定 赋能信息化高质量发展

- 9 《数据治理实战指南》 《数据治理实战指南》【第三部分 实施篇】第9章 数据标准管理

- 10 数据中台 龙石数据中台 V3.8.4 升级 | 数据集成心跳检测,数据处理更稳定