当前人工智能发展正从“模型为中心”转向“数据为中心”,高质量数据集成为大模型竞争的“护城河”。为此,基于《“数据要素 ×”三年行动计划(2024—2026 年)》以及《高质量数据集建设指南(征求意见稿)》,笔者系统性地解构行业级高质量数据集的建设路径,在 AI 时代具有典型意义。

高质量数据集的建设背景

在 AI 产业深度变革的浪潮中,高质量数据集建设呈现出三大显著特征——需求爆发、政策驱动、技术拐点,其发展态势深刻重构着行业格局:

需求爆发

通用大模型向垂直领域的渗透催生了场景化数据资源的井喷式需求。央企加速开放电网调度、核电诊断、金融风控等 30 余个行业核心数据集,推动产业数字化从单点探索迈向系统化升级。这种需求不仅源于技术落地的诉求,更来自 C 端用户对智能服务体验的升级期待,如手机端大模型通过场景重构实现功能跃迁,使普惠化智能服务覆盖数亿用户。市场规模的扩张态势已然明确,即行业共性数据资源库的构建正驱动千亿级市场形成。

政策驱动

国家战略层面对数据要素的系统性部署构成核心驱动力。2017 年国务院印发的《新一代人工智能发展规划》开启了政策先导,2020 年《关于构建更加完善的要素市场化配置体制机制的意见》首次将数据纳入生产要素,而国家数据局联合 17部门联合印发的《“数据要素 ×”三年行动计划(2024—2026 年)》更标志着政策体系的成熟。中央与地方形成协同推进机制。工信部 2016 年发布的《大数据产业发展规划(2016—2020 年)》强化产业支撑体系,贵州省以信用体系与大数据融合试点推动社会治理创新,浙江省通过构建“城市大脑”实现全域数据资源整合。这种“中央顶层设计—部委专项落实—地方场景创新”的三级政策框架,为高质量数据集建设提供了刚性制度保障。

技术拐点

底层技术的突破性演进正颠覆传统数据建设范式。Transformer 架构(一种深度学习模型架构)在推动大模型性能跃升的同时,也暴露出算力分散、领域数据稀缺等瓶颈。当前技术演进呈现两大特征,其一是模型效率革命,如 DeepSeek-R1 系列验证高质量推理数据可提升参数量效率 3 倍,使数据质量取代算力规模成为“新护城河”;其二是架构自主突破,如高质量数据集建设中 95% 国产化率的要求,推动自主芯片 /OS/ 云平台的技术适配。这些突破标志着 AI 发展从“模型优先”转向“数据优先”的新阶段。

高质量数据集的战略定位与意义

在人工智能技术从实验室走向产业化落地的关键转型期,高质量数据集的战略定位已超越基础技术资源范畴,升维为国家数字竞争力的核心基础设施。其战略意义深刻贯穿技术根基、经济引擎与安全壁垒三大维度,构成了支撑“人工智能 +”国家战略落地的系统性支柱。

奠定人工智能发展的技术根基

数据集质量直接决定了人工智能的“智商”水平,这是其最根本的战略定位。国家数据发展研究院院长胡坚波明确指出:“高质量数据集是人工智能真正的‘护城河’”。技术验证亦进行了证明,纽约大学研究发现,医学数据中含 0.001% 错误即会导致模型输出致命误判,而 DeepSeek-R1 模型证明高质量推理数据可使参数量效率提升 300%。此类数据犹如“智能燃料”,通过精准的特征供给驱动模型认知跃升,“数据集质量决定人工智能智商上限”,奠定其在技术生态中的基石地位。

驱动数字经济发展的核心引擎

高质量数据集通过构建“数据—算力—模型”的融合生态,催化出显著的 GDP 增长乘数效应。国家数据局实施的《“数据要素 ×”三年行动计划(2024—2026 年)》将数据集定位为“产业数字化转型升级的加速器”。这种引擎效应建立在数据资产化的创新机制上,主要包括:第一,短期价值释放。央企开放的 30 个行业数据集催生千亿级交易市场,其中金融风控数据集使银行不良贷款识别率提升 29%,直接拉动信贷资产质量优化。第二,长期生态共建。深城交主导建设的交通行业多模态数据集支撑多个大模型训练,有效带动智能网联、低空经济等新产业孵化。

中国信息通信研究院副院长魏亮的“石油炼化”理论深刻阐释其经济逻辑“原始数据需炼化成高质量数据集,才能驱动模型效能转化”,这种“数据炼油厂”角色使其成为新质生产力培育的关键载体。

构筑国家科技安全的战略屏障

在全球化技术竞争背景下,高质量数据集承载着维护科技主权的使命。数据集的国产化率是核心领域数据管控要求,国务院国资委规划发展局副局长胡武婕强调:“行业数据集加速汇聚共享是人工智能自主可控的基础保障”。国家数据局副局长夏冰的论断揭示了其战略本质:“数据集的质效提升是人工智能赋能实体经济的催化剂,需构建部际协同机制筑牢安全根基”。在芯片制程受限的现实环境下,高质量数据集已成为中国突破“算力围城”的核心战略资源。高质量数据集通过“技术根基—经济引擎—安全壁垒”的三角战略架构,确立了人工智能时代的国家基础设施地位。其战略意义不仅在于推动产业实效,更深层的在于构建了中国自主的 AI 发展范式——当算力鸿沟客观存在时,以数据质量优势实现“非对称超越”。随着《高质量数据集建设指南(征求意见稿)》的落地与国家数据要素市场的培育,这一战略支柱将进一步释放“数据 × 产业”的乘数效应,最终支撑中国在全球人工智能治理中实现从“规则接受者”向“标准制定者”的历史性跨越。

高质量数据集的定义和特征

高质量数据集的定义

根据全国数据标准化技术委员会发布的《高质量数据集建设指南(征求意见稿)》和国家标准草案定义,高质量数据集是指经过专业采集、加工处理可直接用于 AI 模型开发与训练,能显著提升模型性能的数据集合,其核心特征体现为“高价值 × 高密度 × 标准化”的三维体系。

高质量数据集的三大特征

高价值指数据集直接驱动模型性能跃升的战略属性。如金融领域数据集通过精准标注交易欺诈模式,使大模型风险误报率降低 55%,凸显其对决策效率的实质提升。高质量数据集需紧密关联应用场景,如工业设备故障预测、医疗影像诊断等,赋能模型在特定领域实现突破性表现。

高密度强调数据的精炼性与信息浓度。通过严格清洗去除冗余噪声,确保样本蕴含有效特征的最大化。典型案例如医疗影像数据集标注病灶边界精度达99.99%,这得益于自动化标注框架与领域专家核验机制的协同,如放射科医生参与审核,实现精准剔除无效样本与强化数据关键特征的统一。

标准化通过分级规范,保障数据可用性。具体可分为三类:一是整合社会通用知识(如基础教育、基础科学数据)的通识数据集,此数据集主要用于支撑通用模型训练;二是聚焦领域基础知识(如金融术语库、交通规则库)的行业通识数据集,理解这类数据需具备基础专业背景;三是面向深度业务场景(如电网故障诊断日志、核电设备运行数据)的行业专识数据集,构建这类数据集需要领域专家的参与。

从本质上来讲,高质量数据集是人工智能时代的“新型基础设施”——其战略价值已超越技术工具范畴,成为驱动产业智能升级、构筑数字主权、重塑全球 AI 竞争格局的核心支点。正如夏冰所强调的:“数据集的质效提升是人工智能赋能实体经济的催化剂,需部际协同构建多元生态”。

高质量数据集的典型建设思路

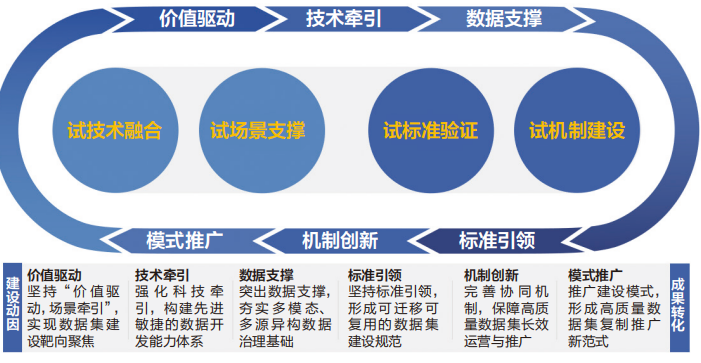

按照国家数据局关于高质量数据集建设的统筹部署,围绕“试技术融合、试场景支撑、试标准验证、试机制建设”四项工作任务,笔者提出高质量数据集典型建设思路(如图1 所示),以确保高质量数据集建设可持续、可复制、可推广,为创新领域和关键行业的智能化转型夯实基础。

图 1 高质量数据集典型建设思路

坚持“价值驱动,场景牵引”,实现数据集建设靶向聚焦

以行业真实业务痛点和应用场景为原点,构建从需求反推数据供给的闭环建设逻辑。这一路径通过深入挖掘垂直领域的核心诉求,精准定位数据资源的价值锚点,避免“为建而建”的资源错配,优先突破人工智能应用最迫切、最容易产生效果、最影响行业高质量发展的领域。在实践中体现为三重协同机制 : 业务需求精准映射、场景化数据供给和动态反馈调优机制。这种价值驱动的建设范式,从根本上改变了传统“数据先行、应用滞后”的粗放模式,使数据集成为破解行业瓶颈的战略工具。正如《“数据要素 ×”三年行动计划(2024—2026 年)》所要求的:需“围绕应用需求牵引、典型场景切入”,最终实现数据资源向生产力要素的高效转化。

强化技术牵引,构建先进敏捷的数据开发能力体系

以大模型、数据合成、超智融合算力等新一代人工智能技术为支撑,创新数据开发模式与技术路径。依托大规模异构算力平台,建立多模态并行处理与加速机制,全面提升数据处理效率与数据质量控制能力。引入大模型自动标注与人机协同能力,在图像、语音、视频等复杂模态上应用预训练模型进行智能标注与初步语义聚类,大幅减少人工成本、提升标注一致性。同步开展数据增强与生成技术研究,通过仿真生成、时序数据合成等手段扩展样本覆盖度,提高长尾问题覆盖能力。围绕高质量训练数据构建目标,集成清洗、脱敏、合规校验、标签审核等自动化工具链,建立敏捷迭代的“采—标—检—训”闭环开发体系,确保高质量数据集供给的稳定性与适配性。

突出数据支撑,夯实多模态、多源异构数据治理基础

构建覆盖数据采集、汇聚、管理、调用的全过程数据治理体系,支持结构化数据、图像视频、音频语音、传感数据等多种模态的统一接入、分级治理与标准转换,打通源系统与训练平台之间的“数据断点”。推进“原始数据—预处理数据—训练数据”三层架构设计,配套元数据管理、数据血缘追踪、数据质量监控等机制,确保数据资产可追溯、可评估、可调优。在全生命周期管理基础上,构建面向不同训练目标的主题化数据仓库,支撑预训练集、微调集、测试集、验证集四类数据集的按需编排与快速交付。

坚持标准引领,形成可迁移可复用的数据集建设规范

围绕数据集“可交付、可训练、可迭代”三大目标,同步推进采集、标注、元数据、注释、脱敏、安全等关键环节的标准体系建设,建立覆盖“源头—处理—交付—调用”的全链路高质量数据集建设标准,形成一整套可迁移、可扩展、可复制的操作规范体系。重点验证数据基础设施建设的接口规范、用户身份管理、接入协议、标识规则、目录描述要求等通用技术要求,并对数据格式、分类指南、质量评估、平台管理等关键领域的标准化要求进行实际对接和测试,打通构建、治理与共享之间的关键环节。

完善协同机制,保障高质量数据集长效运营与推广

构建多主体参与的数据集共建共享机制,形成“行业主导、平台承载、企业参与、多元共赢”的生态格局。以数据资产确权、使用授权、成果收益等机制为核心,推动建立多元共建、共享开放的数据供给模式,激发数据持有方参与积极性。构建基于项目制和联盟制的数据集协同开发模式,实现区域间、企业间的数据流动,促进高质量数据集的跨域融合与能力复用。同时,构建“共建 + 共评 + 共用”的联合攻坚机制,明确各参与方责任边界与数据权益分配方式,为高质量数据集的规模化建设与可持续运营提供保障。

推广建设模式,形成高质量数据集复制推广新范式

坚持“试点先行、模块化拆解、生态化复制”的原则,推动建设成果的广泛推广和应用。围绕“数据集建设技术体系、标准规范体系、平台工具体系、运营治理机制”四大方面,推动“数据采集—清洗标注—平台建设—模型训练—应用落地”的全流程闭环体系在行业内外复制部署。

高质量数据集的业务蓝图

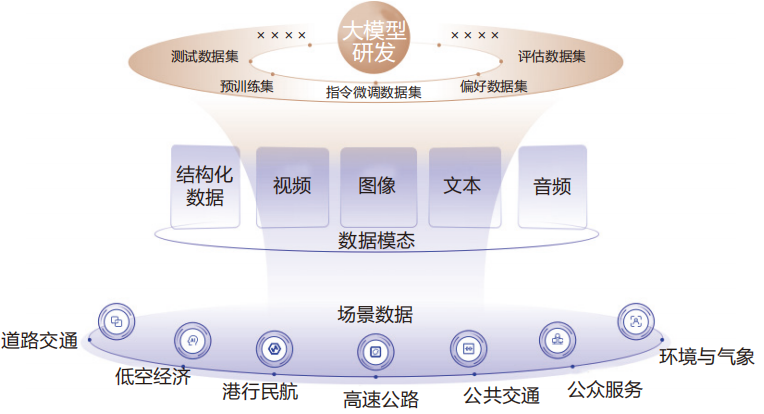

高质量数据集的逻辑架构主要包括数据源、数据集构成,核心是持续生产能够匹配不同行业、领域的大模型进行训练,如图 2 所示:

图 2 高质量数据集的逻辑架构

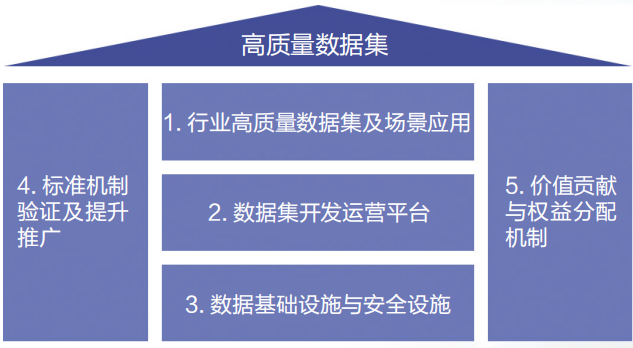

参考国家高质量数据集建设指南和相关标准,高质量数据集的业务蓝图主要包括行业高质量数据集及场景应用、数据集开发运营平台、数据基础设施与安全设施、标准机制验证及提升推广体系、价值贡献与权益分配机制等五大部分,如图 3 所示:

图 3 高质量数据集的业务蓝图

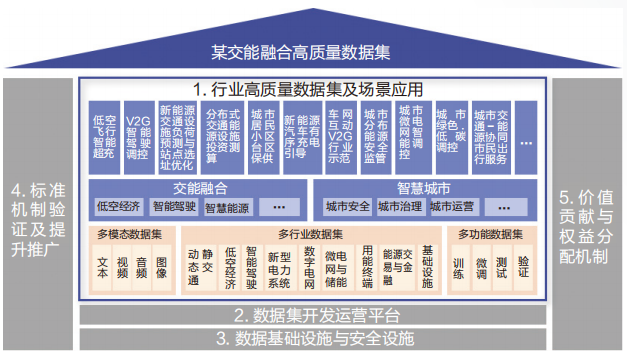

笔者以某交能融合链主型企业申请的行业高质量数据集为例,阐述每一部分的建设内容:

高质量数据集及场景应用

该企业通过开拓新能源及车网互动、智慧交通等业态,在业务创新的同时,利用边缘计算、物联网、移动互联网等技术,采集沉淀了大量的数据。同时结合大数据、大模型、人工智能技术,探索了多个创新场景,从而具备了从数据到价值的链路闭环。一方面,这些数据源能够为高质量数据集提供源源不断的数据;另一方面,众多的应用场景又能支撑大模型的应用价值,从而构建了多模态、多行业和多功能数据集,并且赋能 N 个应用场景。

图 4 某交能高质量数据集及场景应用

数据集开发运营平台

高质量数据集的构建不是一蹴而就的,更不是一劳永逸的,而是一个持续性的运营业务,需要通过“数据需求—规划—采集—预处理—标注—模型验证”,形成一个端到端的闭环,并且利用运营真正吸引数据集的供需双方,从而实现从技术到商业、从数据到价值,打造可持续发展的健康商业模式,实现数据“供得出、流得动”。高质量数据集本质上是一个训练大模型数据的生产线,能够持续不断地获取、加工,给大模型训练供给高质量数据。这个生产线包括八大模块,即运营门户、数据需求、数据规划、数据采集、数据预处理、数据标注、数据验证和技术底座。

图 5 某交能高质量数据集开发运营平台

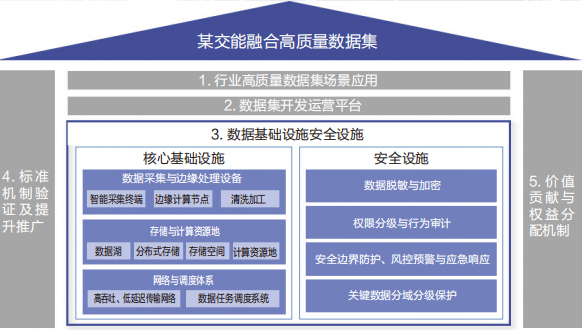

数据基础设施与安全设施

高质量数据集是战略项目,关乎国家信息安全,因此打造一个牢固坚韧安全的基础设施是重中之重。该企业构建了网络预调度体系、存储与计算资源池、数据采集与边缘处理设备为核心的基础设施,同时全链路配套数据脱敏与加密,权限分级与行为审计,安全边界防护、风控预警与应急响应机制,对关键数据进行分域分级保护,从而实现数据的“保安全”。

图 6 某交能高质量数据集基础设施与安全设施

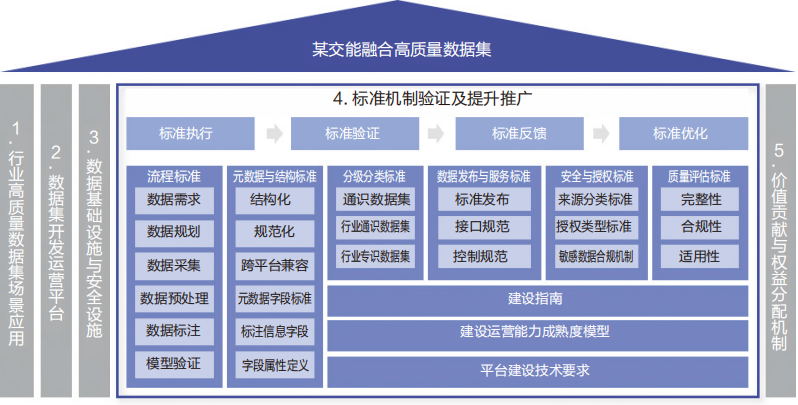

标准机制验证及提升推广体系

高质量数据集的建设还处于早期阶段,尚未形成成熟可复制的统一模式,所以在遵循一些新标准的同时,还需要对这些标准进行验证,并且探索提升和推广体系,从而让后续的建设运营有章可循、持续优化。这方面主要包括从标准执行到标准验证、标准反馈和标准优化的全体系建设,从而能够在不断提升数据集质量的同时,也能够更好的赋能行业。

图 7 某交能高质量数据集标准机制验证及提升推广

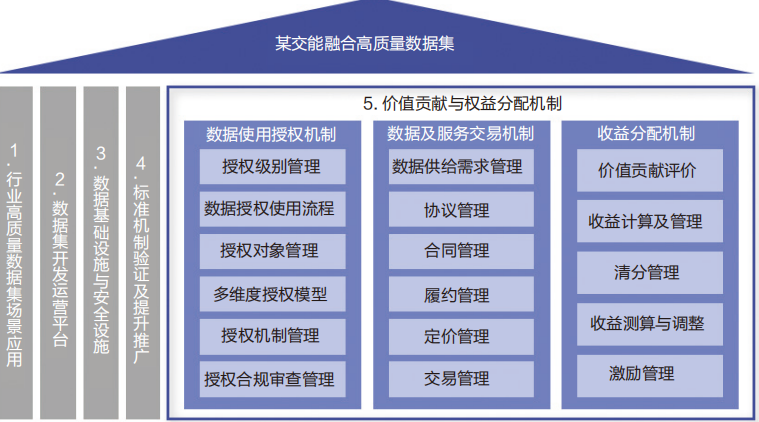

价值贡献与权益分配机制

高质量数据集建成发布后,就会面临价值贡献如何评估、权益收益如何分配的问题。并且只有价值贡献评估客观、公平,权益分配机制遵循“谁贡献,谁受益”的原则,才能够让数据集保有持续的生命力,接入更多有价值的数据源,吸引更多大模型训练方。价值贡献与权益分配机制的建立主要包括三部分内容:数据使用授权机制、数据及服务交易机制、收益分配机制,这些机制能够推动高质量数据集可持续健康发展。

图 8 某交能高质量数据集价值贡献与权益分配机制

高质量数据集的典型建设路径

高质量数据集的建设路径是一项涵盖数据全生命周期的系统工程,需严格遵循规范化的流程框架并结合场景化落地策略,其,核心步骤可归纳为六个阶段,各阶段环环相扣且需动态迭代优化。

数据需求定义(战略锚定与标准构建)

该阶段需从业务场景出发,明确数据集的战略定位与技术规格。依据《高质量数据集建设指南 ( 征求意见稿 )》,需完成三项关键任务:场景化需求分析,针对行业痛点精准锚定数据价值,如金融风控数据集需聚焦欺诈交易特征识别。胡坚波强调需“从医疗、教育等亟需领域切入,避免盲目跟风”,此过程需联合领域专家建立数据质量模型,界定关键指标;数据可获得性评估,预判行业知识壁垒与技术难度,如核电诊断数据集需协调央企设备日志与安全规范;标准化框架设计,基于全国数据标准化委员会的“三类分级”规范(通识 / 行业通识 / 行业专识),定义数据结构与元数据标准。

数据规划(架构设计与资源调配)

本阶段需将需求转化为可执行蓝图,主要包括三大工作内容:一是架构设计,规划存储、计算、安全三大体系,例如深圳交通行业高质量数据集,采用信创云平台整合库表管理、任务调度功能,实现 607TB 视频数据的分布式存储;二是质量计划制定,设定数据清洗、标注精度等 KPI,如医疗数据清洗后错误率需压降至 0.001% 以下以规避模型误判风险;三是工作量预估与资源分配,测算采集标注成本,调配领域专家资源。苏州丝绸纹样数据集建设时整合 222 件文物数字化团队,工作量精确至样本 / 小时级。

数据采集(多源获取与质量控制)

采集过程需融合技术合规“双约束”,多模态采集技术应用,典型的数据集项目采用“前置交换 + 物联网感知 + 互联网爬取”复合方式,归集视频、GPS 等数据。在采集过程中要注意两大保障:质量保障,通过自动化校验规则(如交通视频帧重复率检测算法)拦截无效数据,原始数据清洗率超 30%;合规性保障,严格遵循《数据安全法》,核电数据采集采用“私有化部署 + 区块链溯源”机制阻断敏感信息泄露。

数据预处理(特征强化与噪声剔除)

本阶段决定数据集信息密度,主要的核心操作包括转换验证,例如统一时空坐标;聚合清洗,剔除冗余记录;特征工程,例如金融交易数据经特征选择后,欺诈特征维度浓缩至原始数据的12%,实现高密度表征;样本平衡,采用 SMOTE算法扩增工业设备故障样本。

数据标注(知识注入与精度控制)

标注环节是价值升华的关键,由多级标注体系构成,行业专识数据需领域专家介入,如核电设备诊断标注由工程师定义故障阈值;人机协同机制,采用“预标注 + 人工核验”模式;元数据绑定模式,例如丝绸纹样数据集中每样本关联织造年代、工艺等 32 项元数据,支撑跨产业复用。

模型验证与迭代优化(闭环反馈)

该阶段实现数据价值闭环:基准验证,数据集需通过模型性能测试,如金融数据集使风控模型误报率降幅≥ 55% 方达交付标准;持续优化机制,依托评测工具集监测数据漂移,如深圳交通数据集每季度更新 15% 样本以适配路网变化;跨域流通激活,运用隐私计算技术打通医保—交通数据壁垒,催生慢病出行预警等创新应用。

在当前人工智能从“模型优先”向“数据优先”转型的关键阶段,高质量数据集已成为赋能产业智能升级的战略基础设施和国家数字竞争力的核心支柱。通过系统化构建“价值驱动、技术融合、标准引领、生态协同”的建设体系,我国正加速打通从数据资源到智能应用的闭环路径——以《高质量数据集建设指南 ( 征求意见稿 )》为规范框架,以“数据要素 ×”三年行动计划为实施蓝图,推动金融、医疗、交通等高价值领域实现“原始数据炼化—特征提纯—模型赋能”的质效跃升。未来,随着全生命周期管理、多模态治理、权益分配三大机制的完善,高质量数据集将持续释放三大战略价值——筑牢人工智能技术根基的“护城河”,激活数字经济新质生产力的“新引擎”,以及构筑科技自主可控的“安全壁垒”,最终支撑我国在全球智能时代从数据规则的“接受者”迈向标准制定的“主导者”,真正实现数据要素向创新动能的系统性进化。

(作者史凯单位:精益数据方法论创始人、中国计算机学会数发委执行委员,作者杨慧娟单位:深城交数研智算 PDT、资深数字化顾问。本文刊发于2025年第8期《信息化建设》杂志。)

来源(公众号):浙江数字经济