“您是否知道,许多‘小型’人工智能模型在性能上优于较老、较大的模型——而且仅使用了一小部分资源?”

想象一下,直接在你的智能手机上运行强大的AI助手,无需访问云端,即可在几毫秒内处理你的请求。这并非科幻小说——小语言模型正在将这一切变为现实,触手可及。

连续三年,人工智能界一直痴迷于一个简单的等式:越大越好。

科技巨头们投入数十亿美元构建庞大的语言模型,每一个模型都比上一个更大:

•据传拥有万亿个参数的 GPT-4

•克劳德拥有数千亿

•Meta 的 LLaMA 突破极限,达到 700 亿

每一次突破似乎都遵循同样的模式——更多的参数、更大的功率、更多的可能性。

但2025年发生了一件意想不到的事情。

一 改变一切的剧情转折

随着企业人工智能部署从概念验证阶段过渡到生产阶段,一个令人惊讶的事实浮出水面:越大并不总是越好。

英伟达一项突破性研究表明,40%至70%的企业级人工智能任务可以通过小型语言模型(SLM )更高效地处理——这些紧凑而强大的模型参数少于100亿,具有以下特点:

✓速度比同类巨型设备快 10 倍

✓部署和维护成本降低 5-20 倍

✓更可靠,适用于特定业务任务

✓设备端处理,注重隐私

大型语言模型(LLM)曾经需要昂贵的GPU来运行推理。但最近的进展为经济高效的CPU部署打开了大门,尤其对于小型模型而言。三大变革促成了这一转变:

1.更智能的模型——SLM 的设计旨在提高效率并不断改进。

2.CPU 优化运行时— llama.cpp 、GGUF等框架以及 Intel 的优化可实现接近 GPU 的效率。

3.量化——将模型从 16 位 → 8 位 → 4 位转换,可以大幅减少内存需求,并在几乎不损失准确性的情况下加快推理速度。

二 认识一下小型语言模型

当各大媒体都在追逐最新的十亿参数里程碑时,小型语言模型正在悄然赢得真正的胜利——实际业务部署。

1.市场信号:智能体人工智能正在蓬勃发展

据英伟达称,智能体人工智能(多个专业人工智能代理协作的系统)市场预计将从2024 年的 52 亿美元增长到 2034 年的 2000 亿美元。

2.思想领袖视角:40倍的增长代表了近年来最快的技术普及速度之一。这对企业高管来说意义重大:未来十年人工智能的发展将取决于普及规模,而非参数规模。

3.技术视角:要达到这种规模,人工智能必须从云端转移到边缘环境——智能手机、工厂车间、零售设备、医疗仪器等等。而这只有通过服务层级管理(SLM)才能实现,因为它们对计算和内存的需求更低。

三 快速演化时间线

语音语言模型的发展历程与自然语言处理(NLP)的发展紧密相连:

•2017 年之前:基于规则和统计的模型像n-gram和word2vec

这样的模型捕捉到了基本的词语关联,但缺乏深入的理解。

•2017 年:Transformer 革新了 NLP Transformer 架构

的引入(在著名的“Attention is All You Need”论文中)使得深入的上下文理解成为可能。

•2018–2020 年:大型语言模型诞生

BERT、GPT-2 和 T5 带来了数十亿个参数,达到了最先进的基准。

•2021-2023 年:规模之战

OpenAI、Google、Anthropic 等公司通过将模型规模扩大到数百亿甚至数千亿个参数来展开竞争。

2023年至今:小即是美时代。

随着效率成为首要考虑因素,企业开始训练诸如LLaMA、Mistral、Phi、Gemma和TinyLLaMA等紧凑型模型,这些模型可在笔记本电脑、边缘设备甚至手机上运行。

四 小型语言模型究竟是什么

在了解 SLM 之前,我们先来了解一下什么是语言模型(LM)。

1.语言模型(LM)

一种经过训练的人工智能系统,能够通过预测序列中的下一个单词来理解和生成类似人类的文本。

2.小型语言模型(SLM)

一种轻量级的语言模型,参数更少,针对特定任务或设备端任务进行了优化,成本更低,性能更快。

•参数范围:通常为 1 亿至 30 亿个参数。

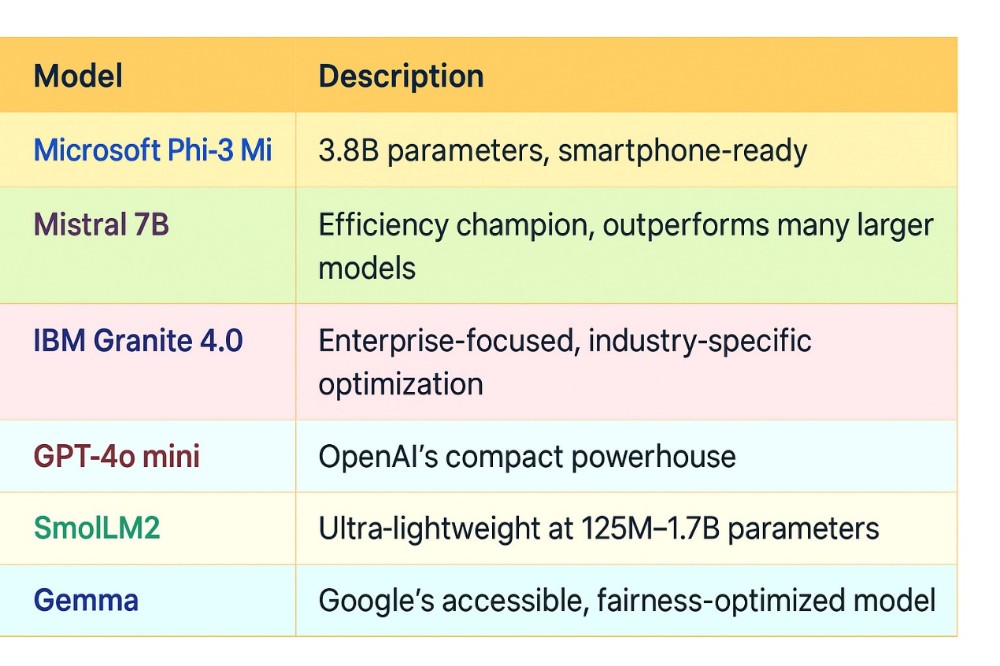

示例:认识小型人工智能领域的明日之星

3.大型语言模型(LLM)

一种功能强大的语言模型,拥有数十亿个参数,在海量数据集上进行训练,能够处理复杂的通用任务。

•参数范围:通常为 100 亿到 1 万亿以上参数。

例如:LLaMA 3 70B → 700亿、GPT-4 → 估计约 1 万亿、克劳德3号作品 → 数千亿。

大型语言模型 (LLM) 提供一流的推理能力,但需要大量的计算、内存和存储空间。而小型语言模型 (SLM) 则针对速度、效率和设备端使用进行了优化。LLM 能够处理广泛而复杂的任务,而 SLM 则擅长特定任务,能够更快地获得结果并降低成本。得益于量化和 GGUF 格式等技术,SLM 现在无需依赖昂贵的云基础设施即可为实际应用提供支持。

你可以把LLM和SLM的区别理解为:

•大学图书馆藏书量(LLM)与专业专家的个人藏书量(SLM)

•一把拥有100种工具的瑞士军刀与一把用于手术的精密手术刀。

4.其他值得了解的LM

(1)检索增强型语言模型(RLM)

这是一种混合语言模型,它结合了语言生成和从外部来源(例如数据库、知识库或网络)实时检索信息的功能。这使得模型无需重新训练即可访问最新、真实且特定领域的数据,从而提高准确性并减少错误预测。

主要特性:集成检索(搜索)和生成(响应)。

参数范围:取决于基础模型——可构建于 SLM 或 LLM 之上。

示例:ChatGPT 与 Browse / GPT 与 RAG 集成;Perplexity AI(基于 RAG 的搜索助手);Microsoft Copilot(带图形检索功能);基于 LlamaIndex 或 LangChain 的 RAG 系统。

(2)中等语言模型(MLM)

中等语言模型 (MLM) 的规模介于小型语言模型 (SLM) 和大型语言模型 (LLM) 之间,通常包含 10 亿到 70 亿个参数,旨在平衡通用性和效率。它比小型语言模型更能有效地处理复杂任务,同时又比大型语言模型更经济高效。

主要特点:具有广泛的通用性,计算需求适中,通常采用 8 位量化进行优化。

参数范围:10 B–70 B 参数。

示例:Meta LLaMA 3 13B、Mistral Mix Medium 13B、Falcon 40B、GPT-3.5 Turbo(~20 B)。

⚙️ SLM 的特性

•参数更少— 通常少于30 亿个参数,使其结构紧凑、重量轻。

•快速推理— 即使在 CPU 或消费级 GPU 上也能快速运行,延迟低。

•资源高效——需要更少的内存、计算能力和能源——非常适合边缘设备或本地部署。

•特定任务— 通常针对特定领域或特定任务进行微调(例如,客户支持、代码补全)。

•注重隐私——可在本地运行,无需将数据发送到云服务器。

•成本效益高——与大型模型相比,训练、部署和维护成本更低。

•更易于微调— 针对特定用例进行定制的速度更快、成本更低。

•便携易部署— 易于分发和集成(尤其是GGUF 格式)。

•环保——由于计算需求减少,碳足迹更低。

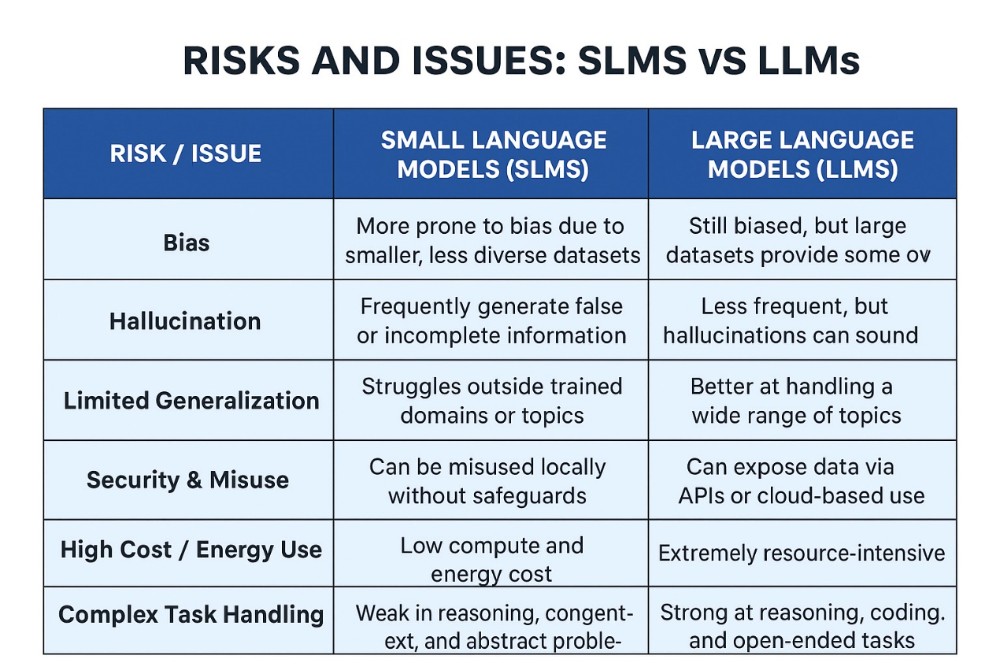

SLM也存在一些风险,下图详细比较了 SLM 和 LLM 的风险。

神奇之处不仅在于参数数量,更在于智能优化技术,这些技术使这些模型能够发挥远超其自身级别的性能。

五 SLM成功背后的技术创新

助力SLM部署的三项突破性技术

SLM 的兴起并非偶然。三大技术变革使得成本效益高的 CPU 部署成为可能,尤其适用于小型型号:

1. 更智能的模型架构:SLM 利用知识蒸馏等先进的训练技术,使较小的“学生”模型能够从较大的“教师”模型中学习,在参数减少 40% 的情况下,仍能保持 97% 的性能。微软的 Phi-3 系列便是这种方法的典范,在消费级设备上运行时,其性能可与 700 亿参数模型相媲美。

2. CPU 优化的推理运行时:围绕 llama.cpp、GGUF 和 Intel 优化技术的生态系统彻底改变了本地 AI 部署方式。这些框架在标准 CPU 上实现了接近 GPU 的效率,使 AI 无需昂贵的硬件投资即可普及。

3. 高级量化技术

或许最具变革性的创新是量化——将模型从 16 位转换为 8 位再转换为 4 位精度。这显著降低了内存需求,并在精度损失最小的情况下加快了推理速度。

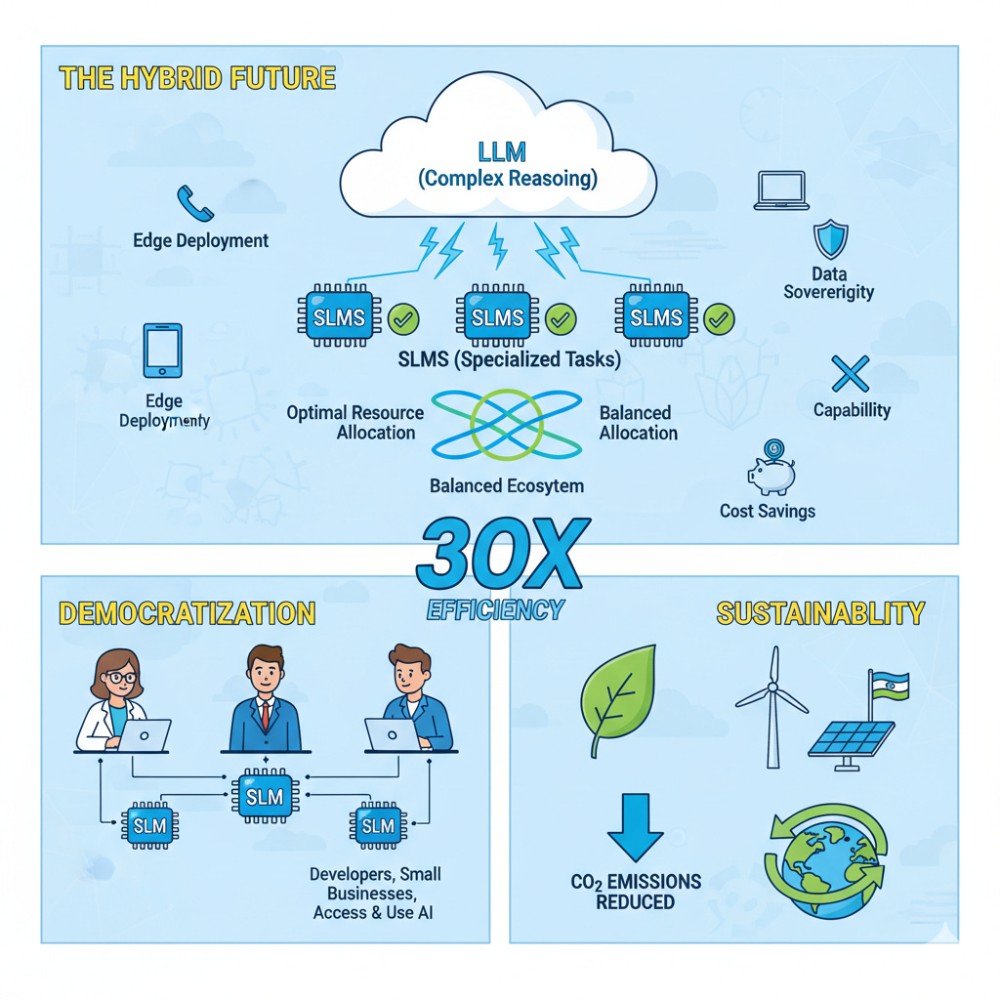

六 混合部署模式

企业正在将两者结合起来,构建混合架构,以优化不同的使用场景。

•大语言模型:负责处理复杂的推理、战略规划和创造性任务

•SLM执行器:管理高频次、特定任务的操作,例如客户支持、数据处理和监控

这种方法既能实现最佳资源分配,又能保持复杂工作流程所需的智能性。

GGUF革命:让AI真正便携

GGUF(GPT生成的统一格式)值得特别关注,因为它代表了我们部署AI模型方式的范式转变。与针对训练优化的传统模型格式不同,GGUF是专门为提高推理效率而构建的。

GGUF的主要优势包括:

单文件可移植性:运行模型所需的一切都高效打包。

•混合精度:智能地为关键权重分配更高精度,而在其他部分使用较低精度。

•硬件灵活性:在 CPU 上高效运行,同时允许 GPU 层卸载

•量化支持:支持 4 位模型,在保持质量的同时大幅减小模型尺寸。

✅理想的CPU部署配置:

•8B参数模型 → 量化到4位时效果最佳

•4B参数模型 → 量化到8位时最优

一个实际的例子:将 Mistral-7B Instruct 量化为 Q4_K_M 格式,可以在配备 8GB 内存的笔记本电脑上流畅运行,同时提供与规模更大的云端模型相当的响应。

七 在本地运行 AI:构建本地 AI 执行架构

步骤 1:基础层

•GGML — 用于高效 CPU 操作的核心张量库

•GGUF — 轻量级二进制格式,支持混合精度量化

•结果:模型存储占用内存最小

步骤 2:推理运行时层

•llama.cpp — 具有原生 GGUF 支持的 CPU 优先引擎

•vLLM — GPU 到 CPU 的调度和批处理扩展

•MLC LLM——跨架构编译器和可移植运行时

•结果:在不同硬件上实现低开销模型执行

步骤 3:部署框架层

•Ollama — 用于无头服务器集成的 CLI/API 封装

•GPT4All — 桌面应用程序,内置 CPU 优化模型

•LM Studio — 用于拥抱脸模型实验的图形用户界面

•结果:简化部署和用户交互

第四步:绩效结果

•低于 200 毫秒的延迟

•低于 8GB 内存要求

•端到端量化管道

•最终结果:实现本地和边缘人工智能推理的民主化

八 实际应用:SLM 的优势所在

1.边缘计算和物联网集成

SLM 最引人注目的应用场景之一在于边缘计算部署。与依赖云的 LLM 不同,SLM 可以直接在以下环境中运行:

•用于实时翻译和语音助手的智能手机和平板电脑

•用于即时异常检测的工业物联网传感器

•用于符合隐私保护规定的患者监护的医疗保健设备

•用于瞬间决策的自动驾驶车辆

•用于离线语音控制的智能家居系统

边缘部署的优势远不止于便利性。它能消除延迟,通过本地处理确保数据隐私,即使在网络连接不佳或中断的情况下也能保证持续运行。

2.企业成功案例

医疗保健:医院部署 SLM 以提供实时诊断辅助,处理敏感的患者数据,而无需承担云传输风险。

机器人技术:制造工厂使用 SLM 在工业自动化中进行自主决策,从而能够对不断变化的情况做出即时反应。

金融服务:银行利用特定任务的 SLM 进行欺诈检测和交易处理,与基于 LLM 的解决方案相比,可节省 10 到 100 倍的成本。

智能人工智能的经济学:SLM 与 LLM 成本分析

在单层模块 (SLM) 和层级模块 (LLM) 之间进行选择,对财务的影响非常大。请看以下实际成本比较:

LLM部署(每日1000次查询):

•API费用:每月3000-6000元

•基础设施:依赖云的扩展

•延迟:平均响应时间为 500–2000 毫秒

SLM部署(相同工作负载):

•本地部署:每月 300-1200 元

•基础设施:一次性硬件投资

•延迟:平均响应时间为 50–200 毫秒

结果如何?SLM部署可以节省5-10倍的成本,同时提供更快的响应时间和更强的隐私控制。

或许,SLM 最深远的影响在于普及人工智能的使用。通过降低计算需求,SLM 可以实现:

•小型企业如何在没有企业级预算的情况下部署人工智能解决方案

•个人开发者可以在消费级硬件上试验人工智能应用

•教育机构无需昂贵的云服务额度即可教授人工智能概念

•注重隐私的组织将在实施人工智能的同时保持数据控制权

这种民主化正在促进以前服务不足的市场和应用场景的创新。

九 展望未来:SLM的未来

SLM 的发展轨迹预示着几个令人振奋的发展方向:

模块化人工智能生态系统:我们正在从单一的模型转向由专门的SLM(系统生命周期管理)协作的系统,每个SLM都针对推理、视觉或编码等特定任务进行了优化。

绿色人工智能:SLM 的能源需求较低,因此对可持续人工智能部署至关重要,从而减少了人工智能广泛应用带来的碳足迹。

移动人工智能革命:移动芯片设计和SLM优化技术的进步使得无需云连接即可在智能手机上直接实现复杂的人工智能。

行业特定智能:我们看到,针对医疗保健、法律、金融和科学应用领域进行微调的特定领域 SLM 正在涌现,它们在专业任务中表现优于通用 LLM。

小结:静悄悄的革命仍在继续

小型语言模型正在重塑人工智能的部署方式,它将智能从云端转移到我们口袋里的设备、工厂车间的传感器以及真正做出决策的边缘系统。企业不再追求规模越来越大的模型,而是拥抱更智能、更高效的基础架构。到2025年,企业能否成功取决于它们采用这种易于上手且可持续的方法的速度。归根结底,人工智能的未来不在于规模,而在于智能,在这方面,小型模型往往比大型模型表现更出色。

人工智能领域正在飞速发展,及时了解这些变化对于做出明智的技术决策至关重要。小型语言模型不仅代表着一种技术趋势,更是对人工智能如何融入我们日常工作流程和业务流程的根本性重新构想。

来源(公众号):数据驱动智能