1.1. 为什么要做数据治理?

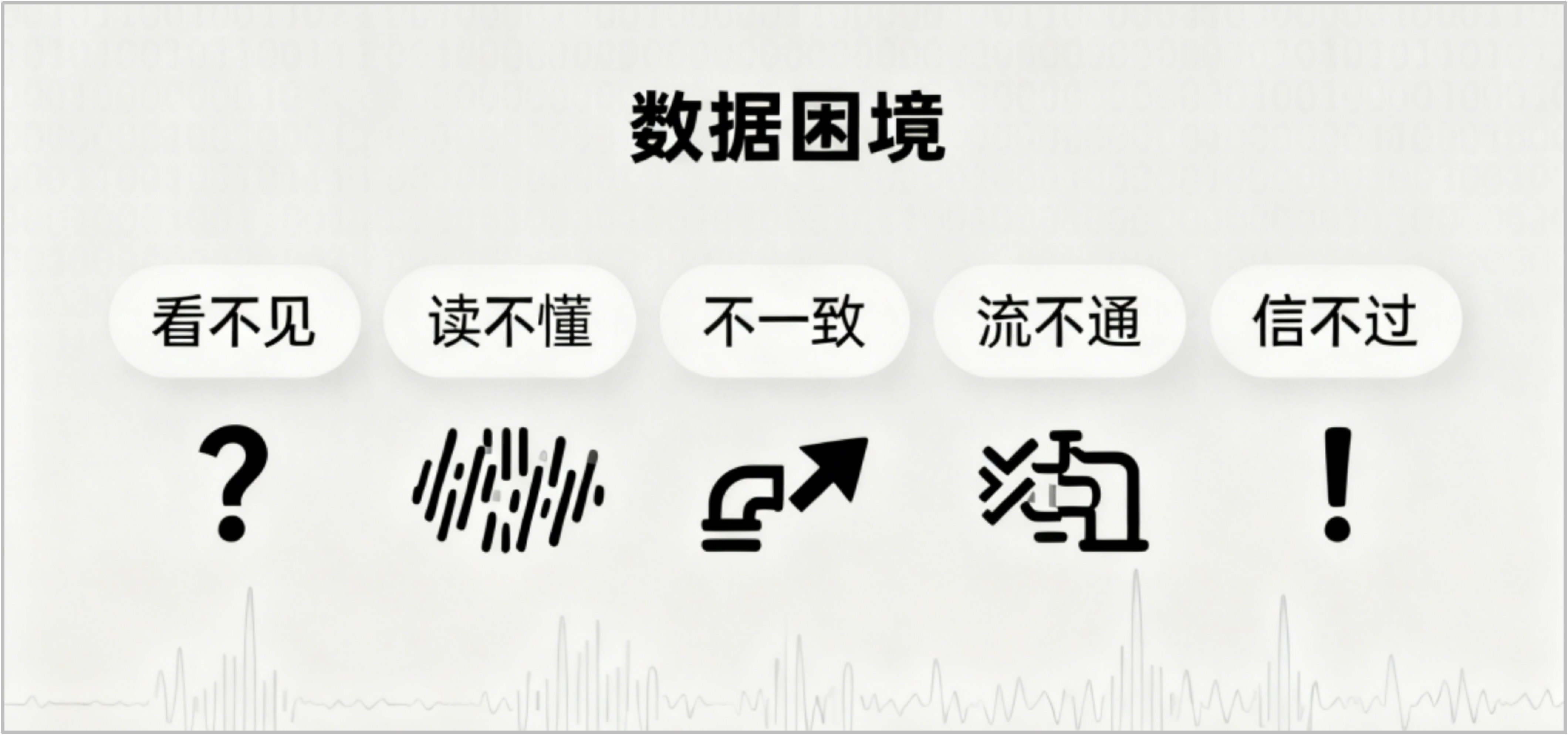

在数字化转型的浪潮中,各个组织已经积累了海量且复杂的数据。然而,许多组织在数据治理和使用过程中,依然面临着“看不见、读不懂、不一致、流不通、信不过”等普遍困境。这些挑战并非孤立的技术问题,而是深刻影响着业务流程、协同效率与战略决策的关键瓶颈。

图 1 数据困境

它们不仅直接导致当前业务流程受阻、协作内耗与决策失误,增加了企业的运营成本与沟通成本,更如同枷锁,禁锢了基于数据的产品创新、精准营销与智能化运营,使企业难以捕捉未来增长机遇。

尤其在人工智能浪潮席卷各行各业的今天,高质量数据更是成为驱动AI模型可靠运行与持续迭代的核心燃料。缺乏有效的管理,不仅传统的数据应用难以为继,前沿的AI项目更将无从落地——低质量的数据将直接导致模型偏见、预测失准与智能应用失效,使得企业对AI的投资难以转化为实际生产力。

根据行业经验,将这些数据困境的具体表现总结为“数据断点” “数据壁垒” “数据方言” “数据迷雾” “数据幻影”与“数据洪流”等典型场景,不仅造成直接的经济损失和资源内耗,更阻碍了数据价值的有效释放。为了突破这些困境,组织有必要采取有效的数据治理措施,将原始数据转化为可用的数据资源,为数据资产化奠定基础,为数据价值具象化提供原料。

图 2 数据治理场景

场景一、“数据断点”——核心业务流程受阻

“数据断点”描述的是核心业务系统彼此孤立,数据未能在需要的时间点到达需要的地方,即数据流断裂,直接阻碍了业务的连续性与协同效率。

【场景案例】

案例一:数据流中断。某制造企业的ERP系统(管理订单和物料)与MES系统(管理生产执行)数据完全不通,导致计划与执行脱节,订单响应迟缓、库存积压。

案例二:数据流延迟。某零售电商的线上、线下及第三方平台间的库存数据无法实时同步。大促时,前端销售火热,后台库存视图却严重滞后,导致大量超卖(有货无货)与客户投诉。

“数据断点”阻碍了核心业务流程的顺畅运行,可能给组织带来直接经济损失,或是削弱客户体验。要想连接上断点,最好是实施面向业务流程的数据集成与同步机制,根据业务对数据及其时效性的要求,采用批量ETL、实时CDC等技术,打通系统间隔阂,确保数据流与业务流程同步,保障运营顺畅。

场景二、“数据壁垒”——多源数据价值难以挖掘

“数据壁垒”描述的是因数据存储分散、技术异构或管理权责不清等原因,导致数据之间形成无形的墙,难以被整合利用。

【场景案例】

案例一:数据整合难。某医院为提升诊疗水平,希望整合EMR(电子病历)、PACS(影像系统)、LIS(检验系统)等十多个独立系统的患者数据,构建统一的“患者360°视图”,以支撑临床决策、风险预警与医学研究。然而,各系统架构各异、数据格式不一,且涉及严格的隐私合规要求,导致数据整合步履维艰。

案例二:业务协同难。某县在自然资源管理中长期面临困境。自然资源、国土调查、不动产登记等关键业务系统的数据由不同部门管理,标准不统一、更新不同步,形成了坚实的“数据壁垒”。例如,企业在办理用地手续时,常因各部门底图中的土地权属、地类信息不一致而遭遇“项目卡壳”,审批流程反复、耗时漫长。

“数据壁垒”使得数据的整体价值被限制在一个个孤岛中,无法支撑深入的洞察与创新。要想突破阻碍,核心是构建分析导向的数据底座,通过平台工具实现多源异构数据的汇聚、清洗与融合,并在全过程中嵌入数据质量与安全管控,为上层分析应用提供高质量、可用的融合数据服务。

场景三、“数据方言”——跨部门协作成本高

“数据方言”是指不同部门间对数据术语的定义、口径和标准不统一,如同各说各的方言,导致沟通成本激增。

【场景案例】

案例一:数据协作难。某集团内部,销售、生产、交付等不同业务领域的计划数据“语言不通”,如对“客户”“订单状态”和“销售额”等核心概念的定义各不相同。制定产销协同计划时,需要投入大量人力进行繁重的数据收集与人工转换、校验,执行一次综合计划耗时超过20小时。

案例二:数据打架。某公司管理层会议上,市场部与财务部汇报的“季度销售额”指标数值差异较大。市场部将“已签约未发货”订单计入销售额,而财务部严格遵守会计准则不予确认。双方各执一词,会议陷入对数据本身的争论,而非基于统一事实进行业务决策。

“数据方言”显著降低了跨部门协作效率,造成内部资源损耗,更动摇了管理层对数据的信任基础。要想平息内耗,各部门能用统一语言“对话”,关键在于制定并推行组织级的数据标准,以“客户”“产品”“供应商”等核心业务实体(即主数据)和高频应用指标为突破口,通过发布唯一、权威的业务术语、数据模型、编码规则与计算口径等,确保数据在全组织范围内“同源同口径”,具有一致、无歧义的业务语义和统计逻辑。

场景四、“数据迷雾”——数据发现与理解困难

“数据迷雾”描述的是数据资源目录缺失或混乱,导致从管理者到业务人员,如同在迷雾中摸索,均无法快速发现、掌控并理解所需数据。

【场景案例】

案例一:业务用数难。某公司需要从发货数据中区分设备保修和维保业务,来分析过保设备服务的情况。然而,数据分析师需要面对几十个IT系统和上千张数据表,既不知道所需数据存储在哪里,也无法理解数据表中诸如“STAT_CD”等字段的真实业务含义,只能反复向IT部门求助,需求响应周期极长。

案例二:战略决策难。某大型集团推进数字化转型,希望整合各子公司客户数据来构建集团级会员体系,实现“集团一盘棋”的战略。然而,总部在规划时却陷入困境,不仅搞不清各子公司有哪些客户数据表,甚至还发现某子公司还独立维护着一套高价值的CRM系统。这种“不知家底”的状况,使得其战略构想因缺乏最基本的数据支撑而悬在空中,难以落地。

“数据迷雾”同时拖慢了宏观战略决策与微观业务应用的效率,使数据价值被掩埋。要想驱散“迷雾”,可以通过数据梳理和元数据管理,摸清数据家底,构建起组织的数据目录,采集并关联技术元数据与业务元数据,为数据标记上清晰的业务标签和血缘信息,为管理层提供全局数据资产全景图来支撑战略决策,也为业务使用者提供可懂的数据导航来加速价值实现。

场景五、“数据幻影”——数据失真引发业务决策失误

“数据幻影”描述的是用于支撑业务决策的数据本身质量低劣、真实性存疑,导致分析结论偏离真相,如同基于幻影做出判断。

【场景案例】

一家初创电商企业,依赖其BI工具的数据分析报表来制定营销策略。然而,由于数据清洗流程不完善,且缺乏数据质量管控机制,其用户数据库中约有20%的数据存在错误或缺失。例如,用户的消费等级标签与历史购买记录不符。市场团队在不知情的情况下,依据这份失真的数据报告,策划了一场针对高消费人群的精准广告投放。结果,不少广告被错误地投放到了低消费人群中,导致转化率远低于预期,营销费用浪费严重。

“数据幻影”使得组织宝贵的资源被投入错误的方向,直接造成经济损失甚至错失市场机会。要想识破“幻影”,关键在于建立贯穿数据生命周期的质量管理体系,如在数据集成阶段进行数据清洗,在数据分析前进行质量评估与问题修复,并对关键业务数据实施持续性的质量监测,确保决策所依赖的数据真实、可靠,让“幻影”变为“实景”。

场景六、“数据洪流”——实时分析瘫痪引发业务行动滞后

“数据洪流”描述的是数据源分散、吞吐量大、时效性要求高的应用环境,数据产生的量级、速度和多样性超出了现有数据架构的处理能力,导致实时数据分析瘫痪。

【场景案例】

某物流企业为动态优化路径,需要实时处理海量的车辆GPS、道路交通、天气与订单数据,来进行智能调度决策,降低运输成本。然而,传统批处理架构无法承载这一股股数据洪流,导致数据处理延迟、路径优化模型失效,车辆调度效率低下,成本控制目标落空。

“数据洪流”使得企业无法对实时变化的业务环境做出及时响应,行动总是慢一步。要想疏导“洪流”,可以构建流批一体的数据处理模式,采用流计算框架应对高速数据流入,并结合数据仓库进行海量存储与治理,确保数据洪流能被高效、可靠地转化为实时决策的动力。

1.2. 怎么做数据治理?

面对上述种种数据困境,孤立、零散的技术修补往往治标不治本。要系统性地解决问题并释放数据价值,组织需要一套贯穿数据全生命周期、业务与技术协同的数据治理方法作为行动纲领。

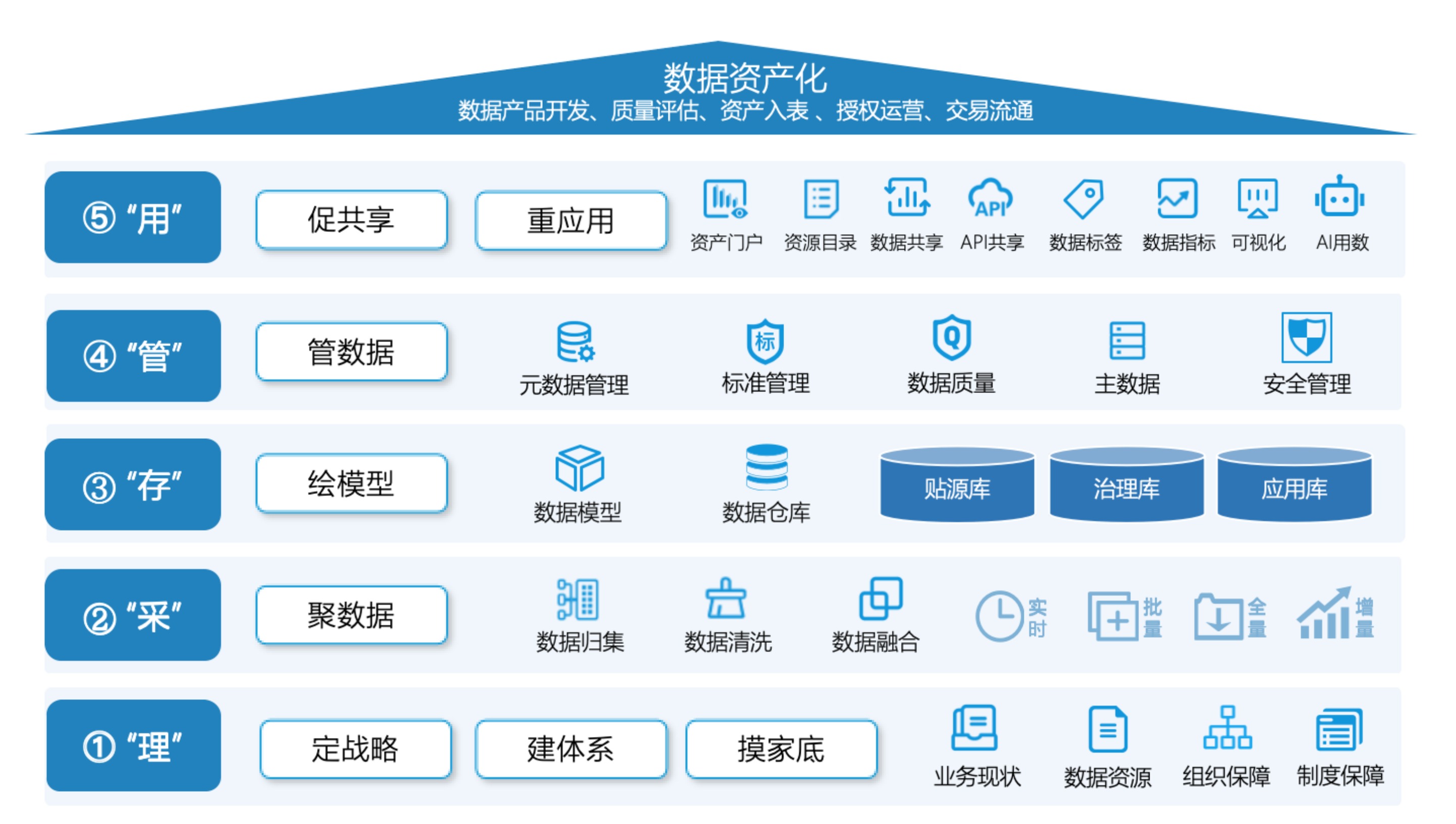

1.2.1. “理采存管用”方法论

结合DCMM标准和DAMA知识体系,融合数据治理实施的“定战略、建体系、摸家底、聚数据、绘模型、管数据、促共享、重应用”八大步骤,形成数据中台“理采存管用”的治理方法论,从规划(理)到获取(采)、存储(存)、治理(管),最终到价值释放(用),覆盖数据全生命周期,助力组织挖掘数据资产价值,支撑业务决策与创新。

图 3 数据治理方法论

- “理”——明确战略,建立体系,盘点家底

“理”是在规划层面,包含“定战略”“建体系”和“摸家底”三个步骤,主要解决数据治理为何做、谁来做、做什么、怎么规范做的问题。

- “采”——按需归集,打通数据

“采”通过“聚数据”,以实时、批量、全量、增量等采集方式,汇聚多源数据,并经过清洗、融合处理,确保数据高质量接入和整合,为后续应用提供“原材料”。

- “存”——模型规划,规范数仓

“存”借助“绘模型”环节,基于数据模型设计,将汇聚和整合的数据合理存储到数据仓库,实现数据结构化组织与分层管理,保障数据能用、易管理。

- “管”——全域管理,提升质量

“管”以“管数据”为核心,通过元数据管理、数据标准管理、数据质量管理、主数据管理、数据安全管理,提升数据质量与合规性,让数据“可用、好用、放心用”。

- “用”——便捷应用,促进数据价值释放

“用”通过“促共享”和“重应用”环节,构建多样化的数据共享和应用场景,实现数据治理的终极目标,让数据真正“活起来”“用起来”,充分激发数据要素的乘数效应。

1.2.2. 数据治理实施八大步骤

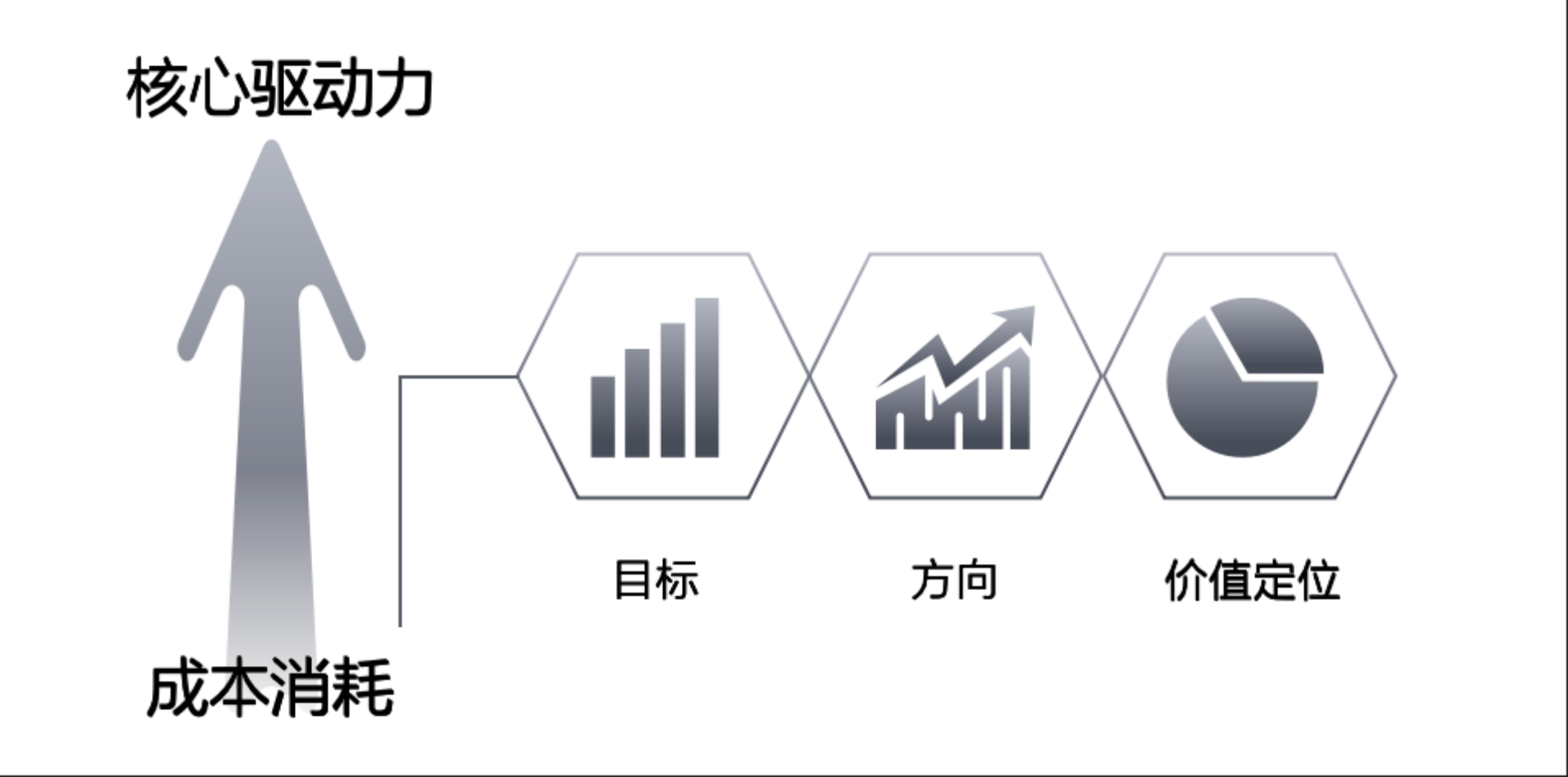

1.2.2.1. 定战略

定战略聚焦数据治理顶层设计,从战略高度明确数据治理的目标、方向和价值定位,确保数据工作与业务战略紧密对齐。该阶段将分散的数据活动提升为组织战略级的行动,推动数据治理从成本消耗转向为业务创新、风险控制和效率提升的核心驱动力,为后续所有数据工作提供总体指引和决策依据。

图 4 “定战略”主要内容

结合组织愿景明确数据治理的定位与目标,制定数据战略实施路径和阶段性目标。它为数据治理提供“方向标”,将零散数据工作对齐业务战略;规划人力、技术及资金等资源投入,建立战略评估与调整机制,制定符合合规与伦理要求的数据治理框架,确保数据工作安全、可控、可持续地开展,助力组织借助数据战略实现业务突破。

1.2.2.2. 建体系

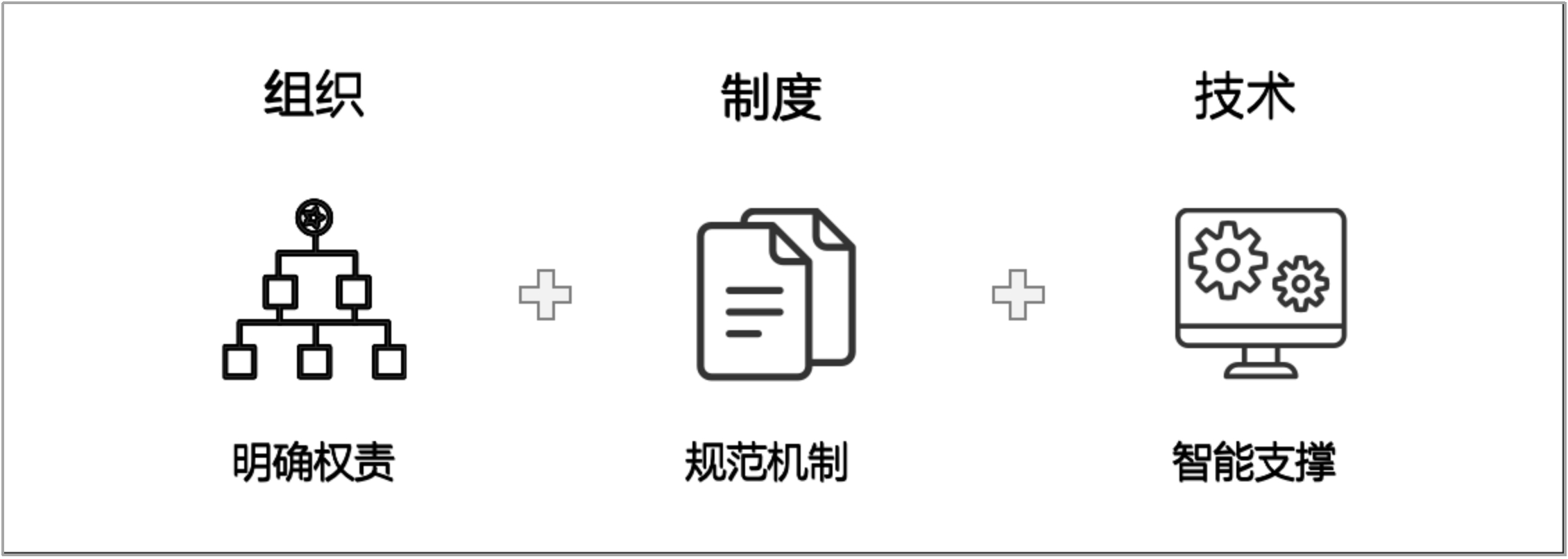

建体系搭建起“组织+制度+技术”三位一体的数据治理框架,消除数据治理中的随意性与不确定性,为数据全生命周期治理提供系统性支撑,保障跨部门协同高效,降低数据治理风险和成本,提升整体效率,为后续数据工作的落地提供稳定、可复用的运行机制。

图 5 “建体系”主要内容

在组织方面,制定组织架构、组织层次和组织职责,明确数据治理角色与权责,如数据治理委员会、业务域数据Owner、数据专员等角色的权责边界,打造治理和技术的专业人才团队,建立一套具有本组织特色的数据治理组织机构。

在制度方面,通过构建管理办法、工作流程、考核机制、长效运营机制等,形成规范、透明、高效的数据治理机制,保障数据工作有章可循、有人负责、有据可依。

在技术方面,构建符合组织的技术框架和产品,引入先进的数据治理技术,实现数据全流程的可视化、可度量、可控制,提升数据治理的自动化和智能化水平,为数据采集、存储、处理、分析与应用提供有力支撑,确保技术与管理的深度融合。

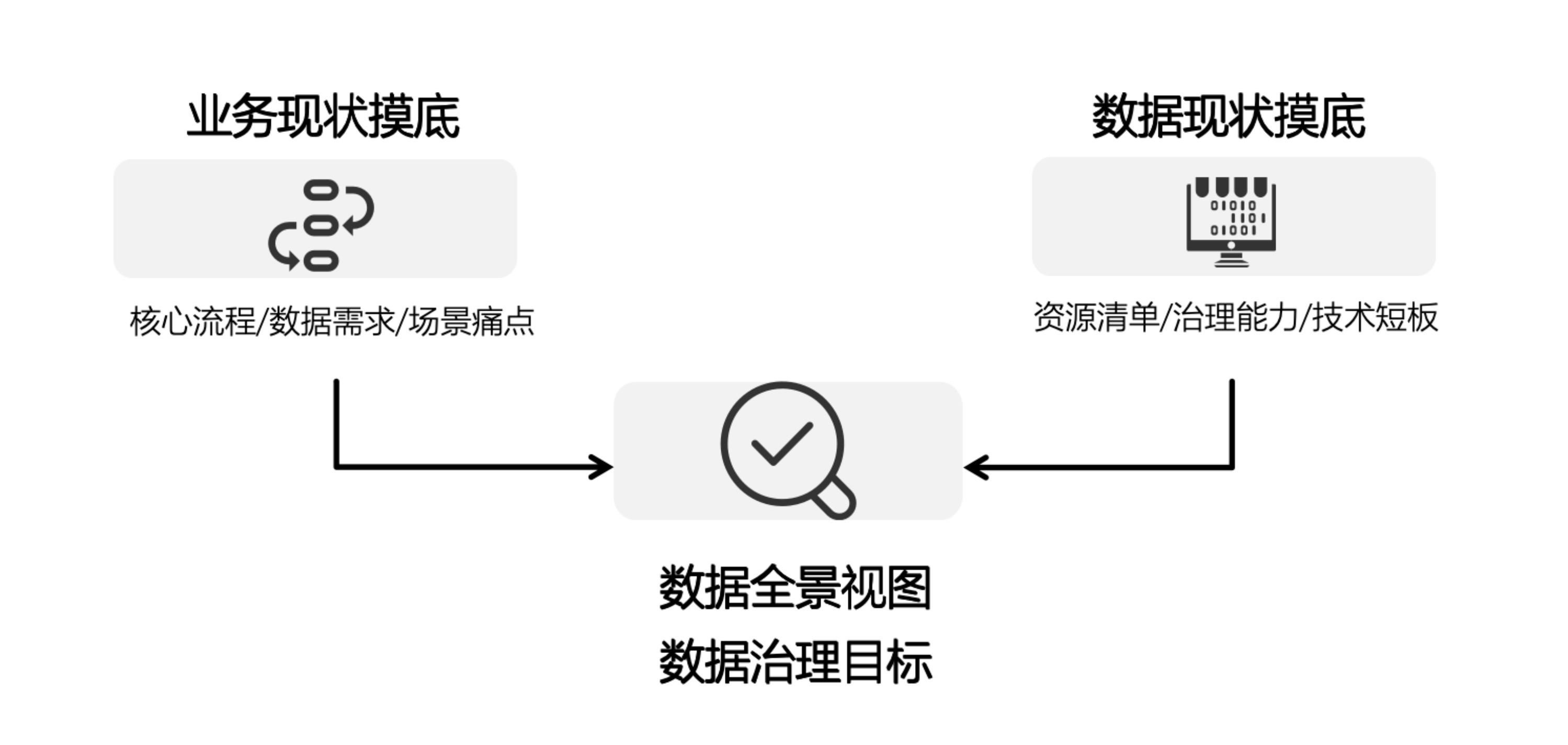

1.2.2.3. 摸家底

摸家底是分析企业战略及业务情况,结合当前大数据现状及未来发展,对组织数据资源的全面盘点与当前数据治理能力的评估。解决“数据在哪里、是什么、质量如何、能否支撑业务”等基础问题,建立组织数据资源的全景视图,确立具体的数据治理目标,为后续的数据归集、建模、治理与应用提供精准的靶向,避免盲目投入与资源浪费。

图 6 “摸家底”主要内容

通过业务现状摸底,梳理各业务域的核心流程与数据需求,识别关键业务场景与数据痛点,明确数据流转路径与关键节点,厘清业务与数据之间的映射关系,明确业务场景对数据的具体要求,为数据资源的归集与治理提供清晰方向。

通过数据现状摸底,评估数据管理现状,全面梳理现有数据管理架构及技术能力短板,明确数据采集、存储、处理、分析等各环节的支撑能力现状,识别薄弱环节与优化空间。同时,对数据资源进行系统性清查,包括数据存储位置、数据形态、内容属性及质量状况等,结合业务视角和技术视角,形成数据资源清单与分布地图。

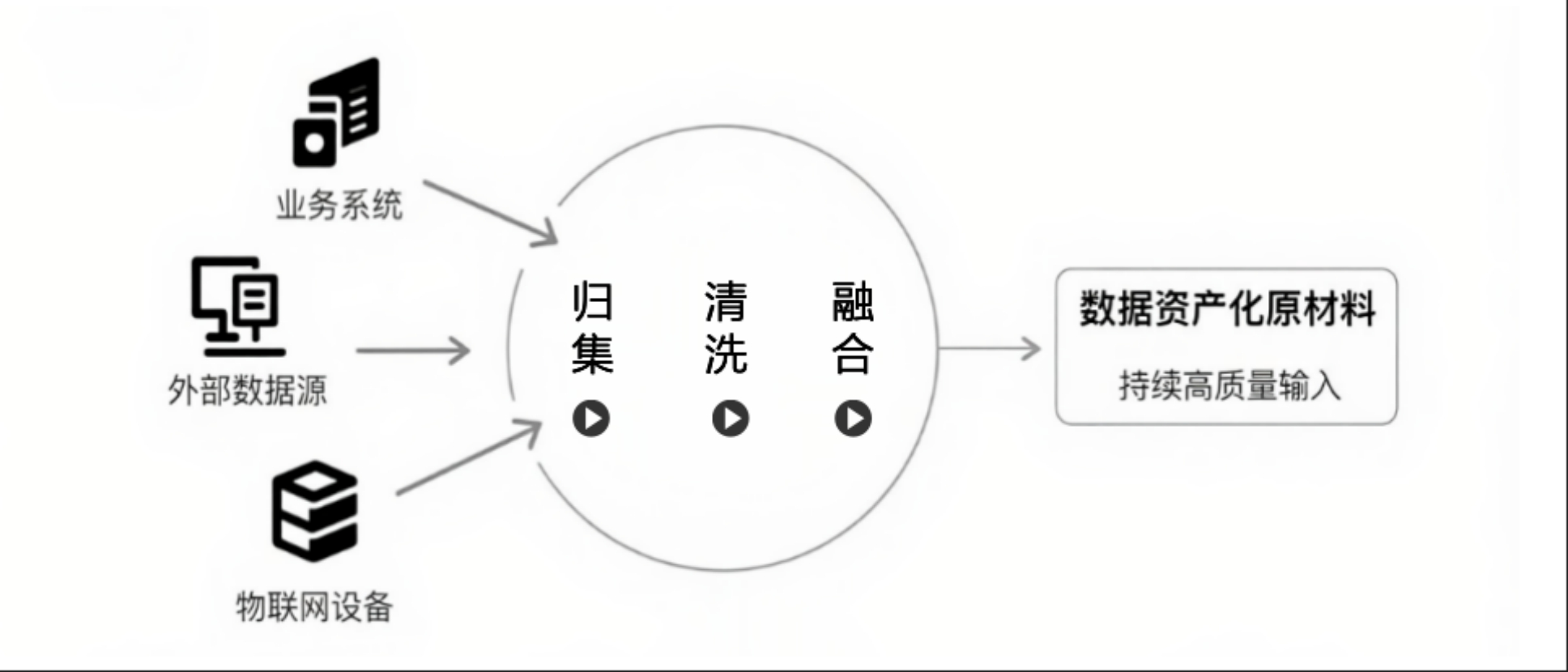

1.2.2.4. 聚数据

聚数据是根据业务场景对数据时效性、完整性的要求,设计多样化采集和清洗策略,构建覆盖多源、多类型数据的汇聚与整合机制,为数据资产化提供持续、高质量的“原材料”输入。通过统一的采集规范,实现跨系统、跨平台、跨格式的数据接入,消除信息孤岛,确保数据资源的“供给端”质量,是数据治理全流程的基础保障环节。

图 7 “聚数据”主要内容

聚数据需兼顾实时性与全面性,既要满足高频业务场景的即时响应需求,也要确保数据覆盖面的完整性。例如,通过批处理技术进行全量采集,一次性迁移历史数据,再通过增量采集,同步数据更新内容,降低传输成本与资源消耗;同时,利用流式处理技术,满足对实时数据的持续接入与处理需求。通过“流批结合”,共同保障数据资源在时效性与覆盖度上的可用性。在此基础上,打通内部数据源、外部数据源和物联网设备,实现异构数据的自动识别与高效采集。

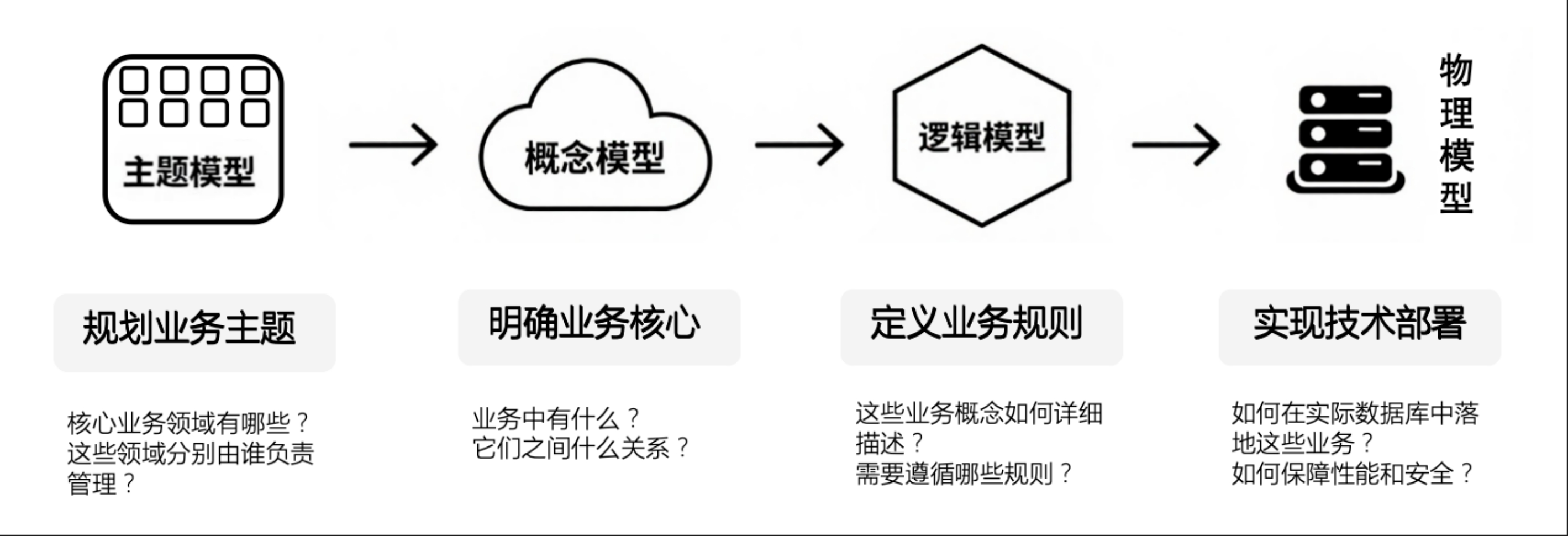

1.2.2.5. 绘模型

绘模型基于“理”和“采”的成果,构建符合业务逻辑的多层次数据模型体系,实现数据的结构化组织与业务化映射。通过搭建“主题模型-概念模型-逻辑模型-物理模型”四级模型架构,以及合理的数据仓库层次划分,将零散的原始数据转化为可理解、可复用的数据资源,为后续数据治理与应用提供标准化的“数据载体”。

图 8 “绘模型”主要内容

数据模型确保数据能够精准匹配业务场景需求,主题模型从全局视角划分业务领域,为后续建模构建整体框架;概念模型聚焦业务主题间的关联关系,梳理业务流程与数据逻辑的对应关系;逻辑模型定义数据的结构规范,确保数据格式的统一性与业务口径的一致性;物理模型侧重数据存储的落地设计,兼顾保障数据访问效率与管理便捷性。通过贴源层、治理层、应用层等分层架构设计,不仅实现原始数据的高保真存储,支撑数据的融合和标准化处理,还增强了数据的复用价值与业务响应能力,保障数据从采集到使用的全链路一致性与高效流转。

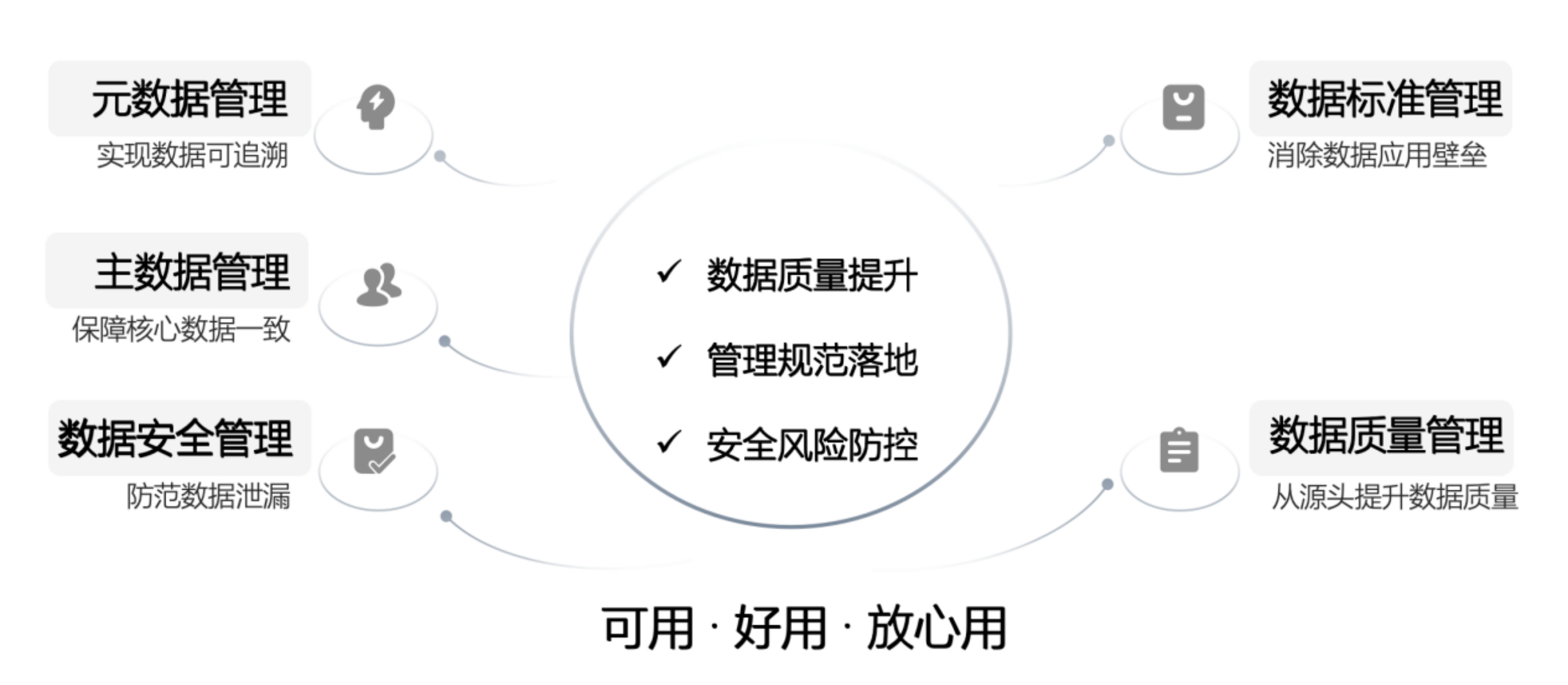

1.2.2.6. 管数据

管数据聚焦于“数据质量提升、管理规范落地、安全风险防控”三大目标,在数据治理框架下,实施数据全生命周期治理,提升数据的质量与合规性,将“不可用、不可靠”的数据转化为“可用、好用”的优质资源,是数据价值释放的关键保障环节。

图 9 “管数据”主要内容

该环节涵盖多维度工作:元数据管理通过梳理数据血缘与业务定义,理清数据的流转路径,实现数据的可追溯与可理解;数据标准管理统一数据定义、口径与格式,提升数据的一致性与规范性,消除数据理解歧义和应用壁垒;数据质量管理建立“发现-分析-整改-评价”的闭环机制,从业务源头解决数据质量问题,切实保障数据资源的准确性、规范性、完整性、一致性、时效性;主数据管理聚焦组织核心数据,通过唯一标识分配、跨系统同步、版本控制等手段,保障核心数据的一致性与准确性;安全管理构建访问控制、传输加密、操作审计、数据脱敏等多层防护体系,防范数据泄露、违规使用等风险。

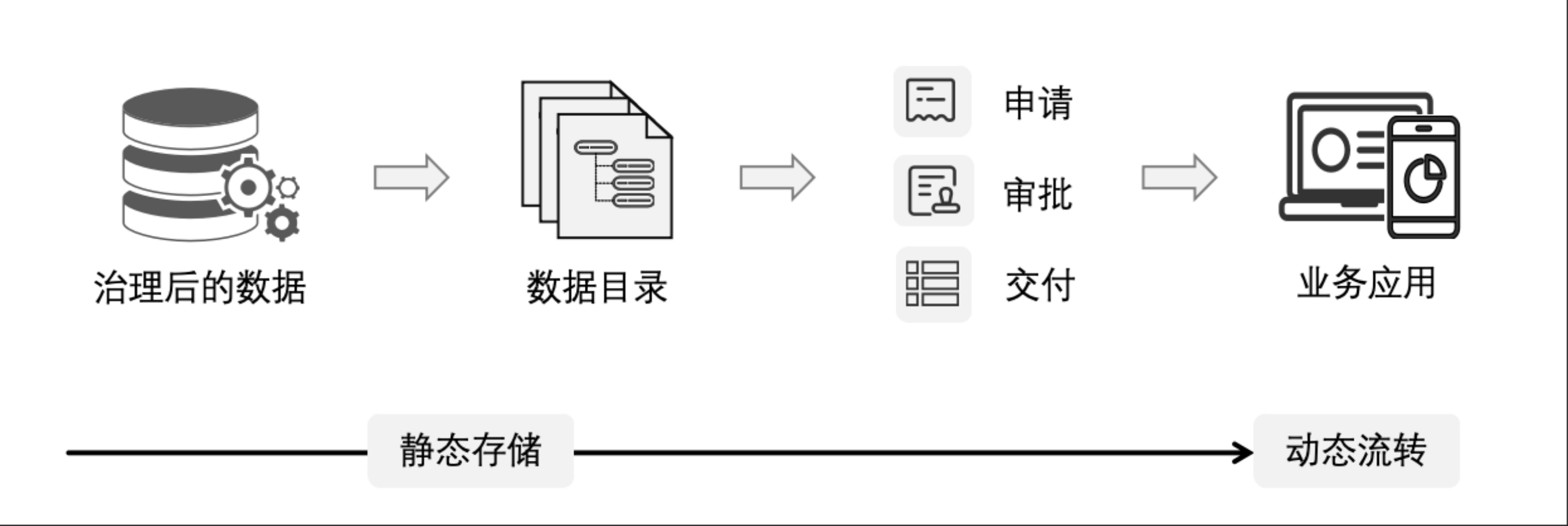

1.2.2.7. 促共享

促共享基于内外部数据需求和业务需求,建立便捷的数据申请与授权机制,提升数据共享效率与使用体验,推动数据在组织内部及外部的高效共享,加速数据资源的流通与复用,将“静态存储”的数据转化为“动态流转”的价值载体,提升跨部门协同效率,支撑业务创新与精细化运营。

图 10 “促共享”主要内容

依托门户和数据目录,将治理后的优质数据目录化呈现,标注数据来源、更新频率、质量等级、适用场景等信息,实现数据目录的统一注册、目录化管理与可视化检索,方便数据用户的快速定位。同时,建立标准化数据共享流程和API规范,明确数据申请、审批、交付的操作标准与权责,保障跨部门、跨系统数据共享的高效性与安全性,支持业务系统快速调用,降低数据使用门槛。

1.2.2.8. 重应用

重应用聚焦业务痛点与创新需求,挖掘和拓展数据应用场景,利用数据标签、数据指标、可视化、AI用数等工具支撑业务发展,将数据资源转化为可量化的业务收益,完成数据治理全流程的价值闭环,驱动数据资源向资产转化,实现数据从“成本中心”转变为“价值中心”。

图 11 “重应用”主要内容

重应用的核心内容是明确数据在各场景中的应用方式、预期目标与价值评估标准。将优质数据资源转化为可落地、可量化的业务成果,推动数据产品打造、资产入表、授权运营资产化进程,实现数据的资产化与商业化。结合组织业务领域挖掘数据应用场景,建立数据标签与指标体系,通过标准化标签、业务指标,帮助非技术人员快速理解与应用数据;借助数据可视化工具,直观呈现数据价值,辅助业务决策。通过AI用数实现自助式、智能化、实时性查询分析,提升数据使用的便捷性与智能化水平。

1.3. 数据治理应当具备哪些能力?

1.3.1. 核心能力简介

数据治理的核心能力包括数据战略、数据治理、数据模型、数据集成与共享、元数据、数据标准、数据质量、主数据、数据安全和数据指标管理等,这些能力贯穿数据全生命周期,支撑“采、存、管、用”各步骤高效协同。

图 12 数据治理核心能力

(1) 数据战略

数据战略是数据治理的“最高章程”。它源于企业战略,为组织的数据工作确立根本性的愿景、目标与行动纲领,是所有数据治理活动的总依据和最高指引。

主要实施任务包含:顶层依据分析(提供制定依据)、数据战略制定(形成包含愿景、方向及行动计划的数据战略)。

(2) 治理体系

治理体系是数据治理的“监察官”。它为各项治理活动的执行建立了组织职责、制度边界与技术架构,确保数据被恰当地管理。

主要实施任务包含:建立组织体系(明确“谁来做”与“谁负责”)、制定制度体系(明确“如何做”与“遵循什么规则”)和确定技术体系(明确“用什么做”)。

(3) 数据模型

数据模型是数据治理的“结构蓝图”。它通过概念、逻辑和物理模型,定义了数据的业务实体、属性、关系与规则,为整个数据架构提供了结构和语义的基石。

主要实施任务包含:数据仓库规划(规划数据仓库分层与模型规范)、数据模型设计(形成各主题域模型)和数据模型维护(确保模型符合实际业务)。

(4) 数据集成与共享

数据集成与共享是数据治理的“数据供应链”。它如同搬运工和加工厂,负责数据从原始“原材料”到可应用“数据资源”的端到端流通。它管理数据的多源采集、清洗转换和数据分发,确保数据能稳定、及时地“供应”给业务应用。

主要实施任务包含明确范围(解决“集成什么”的问题)、数据归集(形成原始备份)、数据清洗(产出规范的数据)、数据融合(形成面向场景、可使用的数据)、数据共享(支撑跨系统、跨组织的数据消费)和集成监控(确保集成过程的稳定与可靠)。

(5) 元数据

元数据是数据治理的“数据导航”。它通过记录数据的来源、含义、血缘关系、加工逻辑、标准、质量和安全等信息,为数据提供全局定位、语义映射与路径规划。它让使用者能快速“定位”并“理解”所需数据,让治理工具能执行策略,是打破数据黑箱、实现智能化治理的基石。

主要实施任务包含:元模型定义(定义业务、技术、操作元数据)、元数据集成和维护(采集、补充并维护元数据)、元数据应用(提供目录查询、血缘分析等服务)。

(6) 数据标准

数据标准是数据治理的“数据宪法”。它确立了数据的命名、定义、格式和值域等准则,是所有数据生产、交换和应用活动的统一规范基础,确保数据在全组织范围内具有一致、无歧义的业务语义。

主要实施任务包含标准规划(形成标准分类框架和优先级)、标准制定(制定业务术语、主数据、数据元等标准)、标准发布(通过组织级平台统一发布标准)、标准落地(在数据仓库和业务系统中落地标准)和标准维护(确保标准与业务发展保持同步)。

(7) 数据质量

数据质量是数据治理的“健康医生”。它通过建立全面的“体检”标准(质量规则),对数据资源进行持续性的健康监测、根因分析、源头整改和质量评价,确保数据远离“疾病”、充满活力,为业务决策提供强健可靠的数据支撑。

主要实施任务包含质量范围确认(明确数据质量管理范围)、质量评估(深度发掘数据质量问题)、问题分析(追溯问题来源并进行根因分析)、源头整改(执行“治标”的数据纠正与“治本”的预防性措施)和质量评价(定期发布质量评估报告)。

(8) 主数据

主数据治理是核心业务实体的“黄金记录源”,它对客户、产品等关键业务实体进行统一定义、集中清洗与发布,确保在全组织范围内,每个核心实体都存在唯一、准确且权威的“黄金版本”,是跨系统协作的基石。

主要实施任务包含主数据识别(识别核心主数据实体)、主数据标准制定(制定统一的编码规则与模型标准)、主数据集成和清洗(形成唯一黄金记录)、主数据分发(将权威主数据分发给应用系统)和主数据运营(确保主数据全生命周期可控)。

(9) 数据安全

数据安全是数据治理的“防火墙”。它以分类分级为基础,构建了一套贯穿数据全生命周期的防御体系,通过访问控制、加密、脱敏等手段,抵御内外部威胁,确保数据的保密性、完整性和可用性不受侵犯。

主要实施任务包含数据分类分级(形成数据分类分级清单)、管控策略制定与落地(制定并落地安全管控策略)、数据安全运营(确保安全策略合适且有效)。

(10) 数据指标

数据指标是衡量业务绩效的“价值仪表盘”。它将分散的数据转化为一套统一、口径一致的量化度量,为管理决策、绩效评估和运营优化提供实时、客观、一致的依据,是驱动组织精准行动、实现业务目标的仪表盘。

主要实施任务包含:指标定义(形成标准的指标定义)、指标开放(实现指标的计算逻辑)、指标运营(确保指标应用及时且准确)。

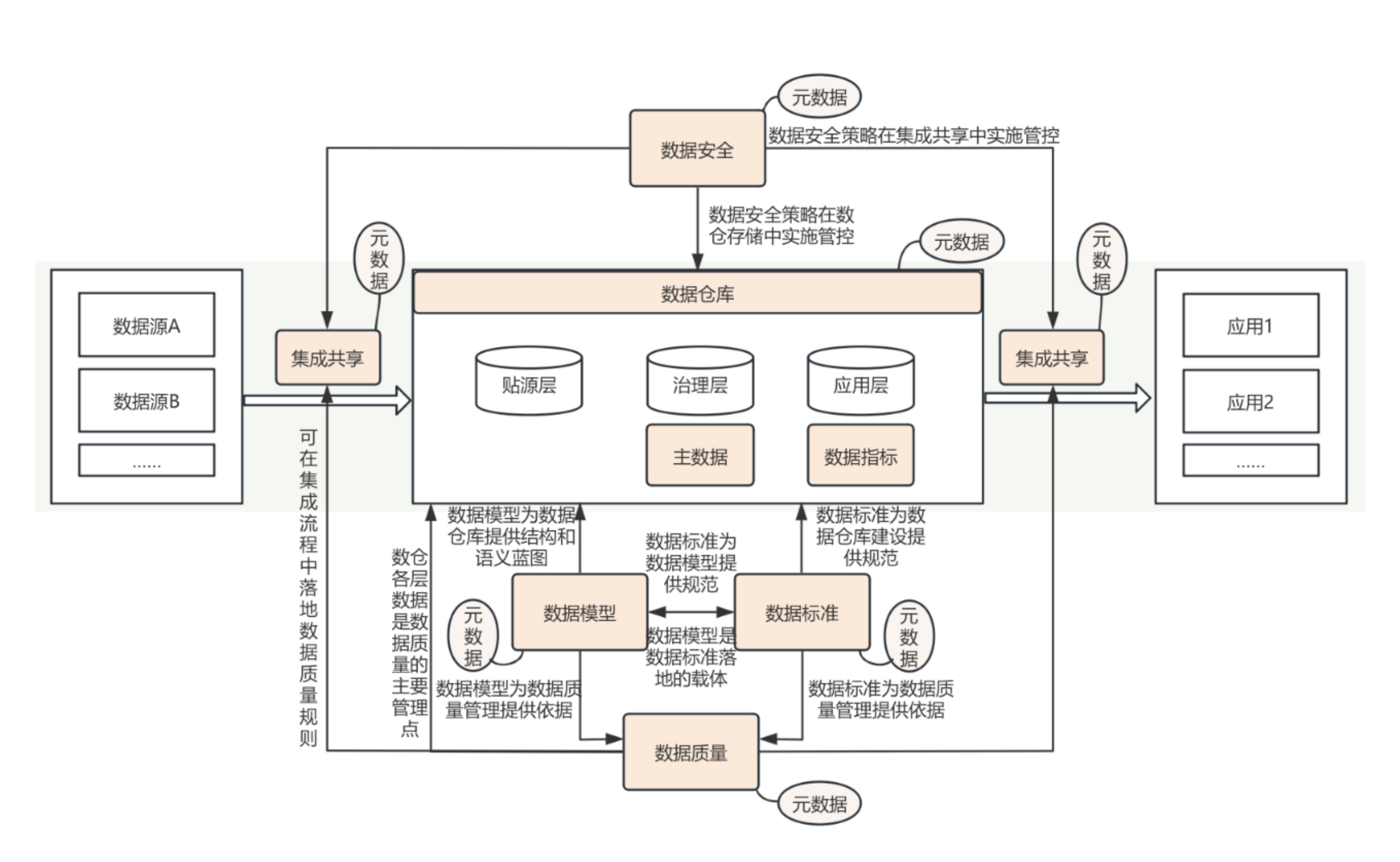

1.3.2. 能力协同关系

在成功的数据治理活动中,各能力模块并非孤立存在,而是紧密联动,形成一个持续优化的闭环。“数据标准”和“数据模型”负责设计和制定规则,“元数据”全面收集信息的同时,又提供全域信息服务,“数据质量”与“数据安全”在“集成共享”流程中保驾护航,最终共同服务于“主数据”、“指标数据”等核心数据的价值实现,形成协同共进的强大合力,为数据治理方法论落地提供坚实的能力支撑。

图 13 核心能力协同关系

(1) 模型与标准:规范与落地的统一

数据标准为模型设计提供统一的业务语义与技术约束,而数据模型则是标准在具体主题域中的落地体现。二者协同工作,从设计源头确保共同奠定了清晰、稳定的数据架构,为数据集成、加工和应用提供了统一的规范基础,是构建高质量数据的核心前提。

(2) 质量与标准、模型:检验与保障的闭环

数据标准和数据模型为数据质量提供了衡量基准和依据;反之,数据质量的评估和分析结果又推动反向驱动标准完善与模型优化,确保数据规范符合业务要求,形成“定义-检验-改进”的良性循环。

(3) “集成、数仓”与“安全、质量”:流动与存储中的关键控制点

数据集成过程(动态的数据)和数据存储过程(静态的数据)是数据安全策略落地和数据质量问题暴露与修复的关键环节。将安全和质量管控嵌入集成流程,能在数据流动的源头实施防护与校验;同时,对存储在数据仓库中的数据进行持续的安全监控与质量评估,构成了纵深防御体系。它们共同从数据的动态流转与静态存储两个维度,全面保障数据的“出生健康”与“持续可信”。

(4) 主数据与标准、质量、模型:核心实体的精益管理

主数据是数据标准在核心业务实体上的集中执行者,确保标准中的业务定义与编码规则得到贯彻;同时,它高度依赖于数据模型,为这些核心实体提供必须遵循的结构定义与关系蓝图;而数据质量工作通过持续的监测与修复,保障其“黄金记录”的权威性。三者共同确保主数据在全域范围内一致且可用。

(5) 数据指标与标准、质量、模型:业务价值的精准表达

数据指标是数据标准在业务度量上的直接体现,其口径必须严格遵循标准定义。数据质量保障了指标计算的准确性与可靠性,而数据模型则为指标提供了稳定的数据来源和计算逻辑。一个权威的指标,是标准、质量和模型共同协作产出的“可信成品”。

(6) 元数据的中枢作用:全域信息的统一枢纽

元数据作为体系的统一信息枢纽,系统性地收集并管理来自各模块的核心信息。它记录了标准的业务定义、模型的结构语义、质量的评估规则、安全的分类分级标签,以及集成的血缘关系。在此基础上,它为所有数据活动提供了统一的上下文查询与服务,确保了数据在定义、理解、使用和管理上的全域一致性,是实现协同治理的基石。

(或访问:https://pan.quark.cn/s/caf6500cd731?pwd=wRkN)

本书采用了开放式共创的编撰模式。我们坚信,内容的可靠性与实践性来自持续的交流与共创。因此,我们诚挚邀请您——每一位关注数据治理的同行者、实践者与思考者——加入本书的共创计划。

如果您在阅读过程中,提出关键修正、贡献具有借鉴价值的优质案例,或补充了不可或缺的核心内容,我们将诚挚邀请您成为本书的共同署名共创者,并参与后续的专题研讨与行业交流,共同推动数据治理领域的实践进步与生态发展。

愿这本书不仅是一本指南,更是一次连接行业、凝聚共识、共创未来的行动。